微軟研究院近期揭曉了其最新的大型語言模型(LLM)成果——BitNet b1.58 2B4T,這款模型憑借獨特的1.58位低精度架構設計,成功將模型大小壓縮至僅0.4GB,引起了業界的廣泛關注。

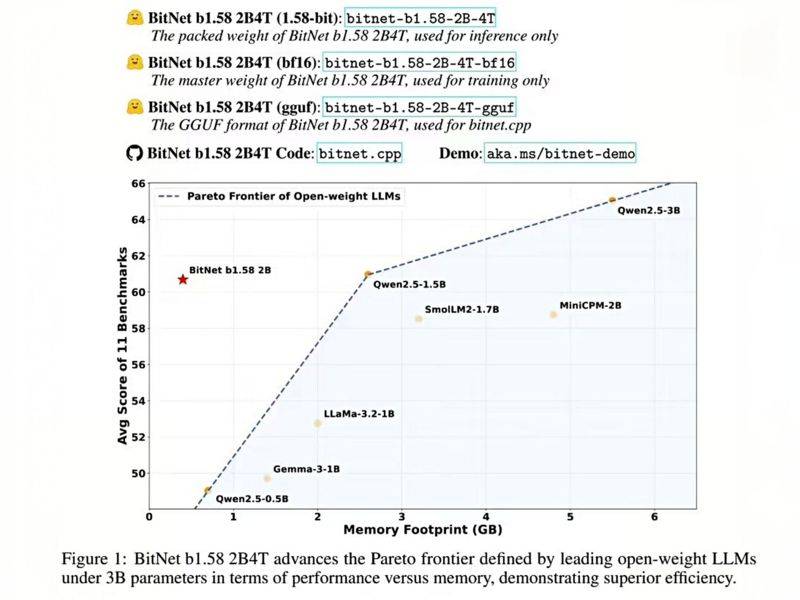

BitNet b1.58 2B4T擁有20億參數,其最大的亮點在于采用了原生1-bit訓練技術,這一創新直接挑戰了傳統的訓練后量化方法。這種新方法不僅保持了模型的高性能,還顯著降低了對計算資源的需求。在與同規模全精度模型的對比中,BitNet b1.58 2B4T展現出了相近的性能,而在內存占用方面,其非嵌入內存僅為0.4GB,遠低于競品Gemma-3 1B的1.4GB和MiniCPM 2B的4.8GB。

為了實現這一突破,BitNet b1.58 2B4T摒棄了常規的16位數值表示,轉而采用了定制的BitLinear層,將權重限制為-1、0和1三種狀態,形成了一種高效的三值系統。這種設計使得每個權重僅需約1.58位信息存儲,從而極大地節省了內存空間。模型的層間激活值采用了8位整數量化,形成了獨特的W1.58A8配置。微軟團隊還對Transformer架構進行了優化,引入了平方ReLU激活函數、標準旋轉位置嵌入(RoPE)以及subln歸一化等技術,確保了低位訓練的穩定性和高效性。

在性能表現上,BitNet b1.58 2B4T在GSM8K(數學)和PIQA(物理常識)等基準測試中展現出了優異的性能,其整體性能與主流的1B-2B參數全精度模型相當。同時,該模型在能耗和解碼延遲方面也具有顯著優勢,每token能耗僅為0.028焦耳,解碼延遲低至29毫秒。這些特性使得BitNet b1.58 2B4T在實際應用中具有更高的能效比和更快的響應速度。

微軟團隊并未因這一成就而滿足,他們正計劃對BitNet b1.58 2B4T進行進一步優化。未來的優化方向包括增強對GPU和NPU的支持,以進一步提升模型的運行效率;將上下文窗口延長至4096 token,以提高模型處理長文本的能力;探索多語言模型的開發,以滿足不同語言環境下的應用需求;以及研究更大規模模型的硬件協同設計方案,以推動人工智能技術的進一步發展。

目前,BitNet b1.58 2B4T已在Hugging Face平臺以MIT許可證發布,供社區成員進行測試和應用。然而,需要注意的是,要充分發揮該模型的高效性,需要依賴微軟提供的專用C框架(bitnet.cpp)。使用標準工具(如Hugging Face transformers庫)可能無法完全展現其速度和能耗優勢。