近期,谷歌DeepMind團隊與約翰·開普勒林茨大學(xué)的LIT AI實驗室攜手,在提升語言模型決策能力方面取得了突破。這一成果通過強化學(xué)習(xí)微調(diào)(RLFT)技術(shù)實現(xiàn),旨在解決當前語言模型在決策過程中的一系列問題。

語言模型,經(jīng)過海量互聯(lián)網(wǎng)數(shù)據(jù)的訓(xùn)練,已展現(xiàn)出超越單純文本處理的潛力。它們能夠利用內(nèi)部知識推理,在交互環(huán)境中做出行動選擇。然而,這些模型在決策時仍面臨諸多挑戰(zhàn)。例如,它們能夠推導(dǎo)出正確的策略,但在執(zhí)行時卻常常力不從心,形成了所謂的“知道卻做不到”的鴻溝。模型還傾向于過度追求短期的高回報,而忽視了長期的利益,這被稱為“貪婪選擇”。更小的模型則容易陷入機械重復(fù)常見動作的困境,即“頻次偏見”。

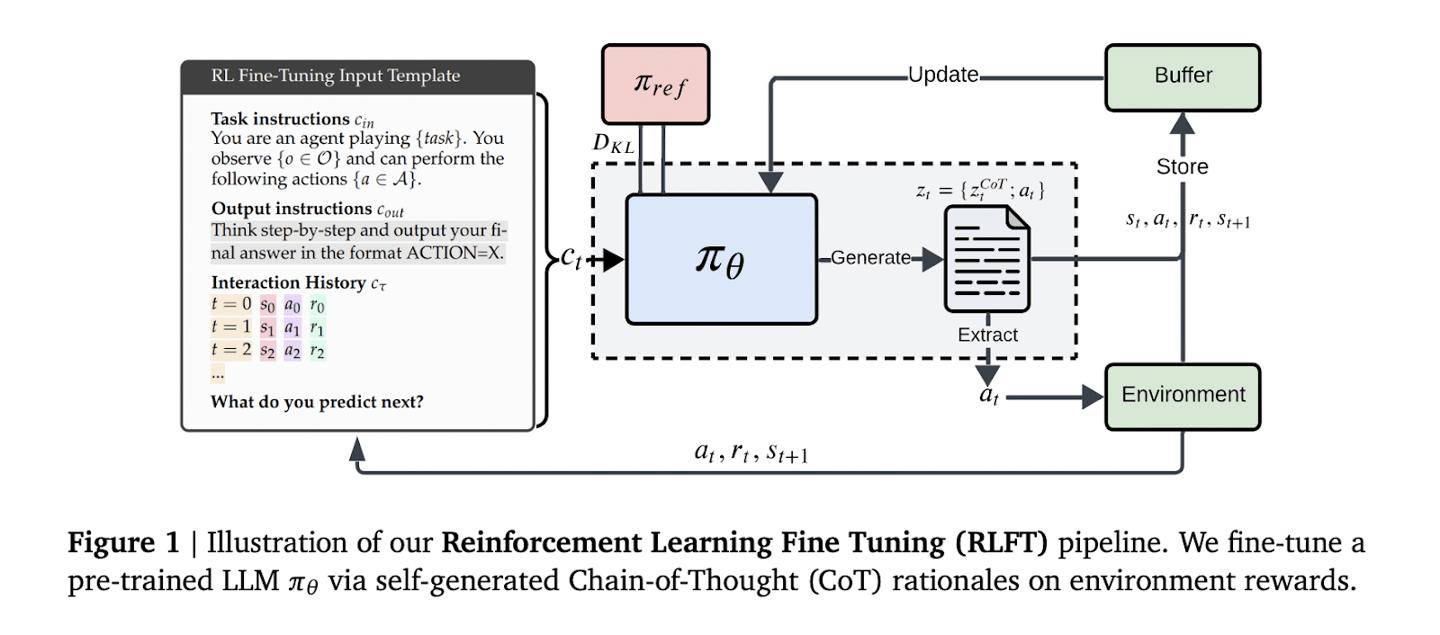

傳統(tǒng)強化學(xué)習(xí)方法,如UCB算法,雖然在平衡探索與利用方面表現(xiàn)出色,但難以從根本上解決語言模型內(nèi)在的推理與行動脫節(jié)問題。為了克服這一難題,DeepMind團隊創(chuàng)新性地采用了強化學(xué)習(xí)微調(diào)技術(shù)。該技術(shù)以模型自生成的思維鏈為訓(xùn)練信號,通過評估每個推理步驟對應(yīng)的行動獎勵,引導(dǎo)模型優(yōu)先選擇既邏輯自洽又實際高效的行動方案。

在具體實施過程中,模型根據(jù)輸入的指令和行動-獎勵歷史,生成包含推理過程和動作的序列。這些序列通過蒙特卡洛基線評估和廣義優(yōu)勢估計進行優(yōu)化。對于無效的動作,系統(tǒng)會觸發(fā)懲罰機制。同時,獎勵塑造技術(shù)既確保了輸出格式的規(guī)范性,又保留了足夠的探索空間。

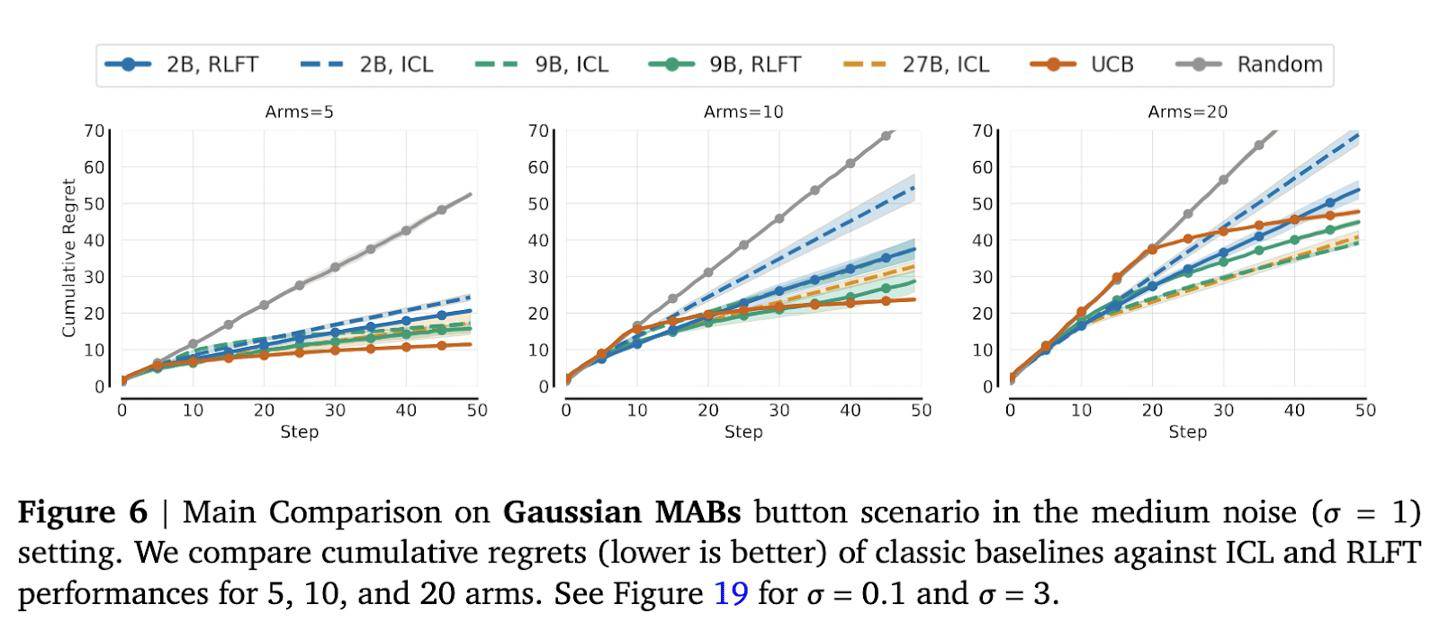

為了驗證這一技術(shù)的有效性,研究團隊進行了多項測試。在多臂老虎機測試中,面對10臂和20臂的情況,模型的動作覆蓋率顯著提升。特別是在10臂測試中,2B參數(shù)模型的動作覆蓋率提高了12個百分點。而在20臂測試中,雖然改善幅度較小,但頻次偏見率從70%驟降至35%,仍然具有顯著意義。

在井字棋實驗中,模型的表現(xiàn)同樣令人矚目。與隨機對手對戰(zhàn)時,模型的勝率提升了5倍。而與最優(yōu)蒙特卡洛樹搜索代理的對戰(zhàn)中,模型的平均回報從-0.95歸零。值得注意的是,27B大模型在生成正確推理的概率方面達到了87%。然而,在未進行微調(diào)時,僅有21%的模型會執(zhí)行最優(yōu)動作。這一強化學(xué)習(xí)微調(diào)技術(shù)有效地縮小了這一差距,顯著提升了模型的決策能力。