近日,Predibase平臺宣布了一項重大創(chuàng)新,正式推出了業(yè)內(nèi)首個端到端的強化微調(diào)平臺(RFT),這一消息迅速在AI領(lǐng)域引起了廣泛關(guān)注。

Predibase強調(diào),DeepSeek-R1的開源項目不僅揭示了強化學習微調(diào)在大模型訓(xùn)練中的關(guān)鍵作用,更為他們開發(fā)RFT平臺提供了靈感。該平臺旨在簡化并優(yōu)化大模型的微調(diào)過程。

與傳統(tǒng)的監(jiān)督式微調(diào)方法相比,RFT平臺摒棄了對大量標注數(shù)據(jù)的依賴,轉(zhuǎn)而采用獎勵機制和自定義函數(shù)來驅(qū)動持續(xù)的強化學習。這一平臺集成了無服務(wù)器和端到端的訓(xùn)練方法,使得從數(shù)據(jù)管理、模型訓(xùn)練到應(yīng)用部署的全過程都可以在單一平臺上無縫完成。用戶只需通過瀏覽器界面設(shè)定微調(diào)目標并上傳數(shù)據(jù),即可輕松完成以往繁瑣復(fù)雜的大模型微調(diào)任務(wù)。

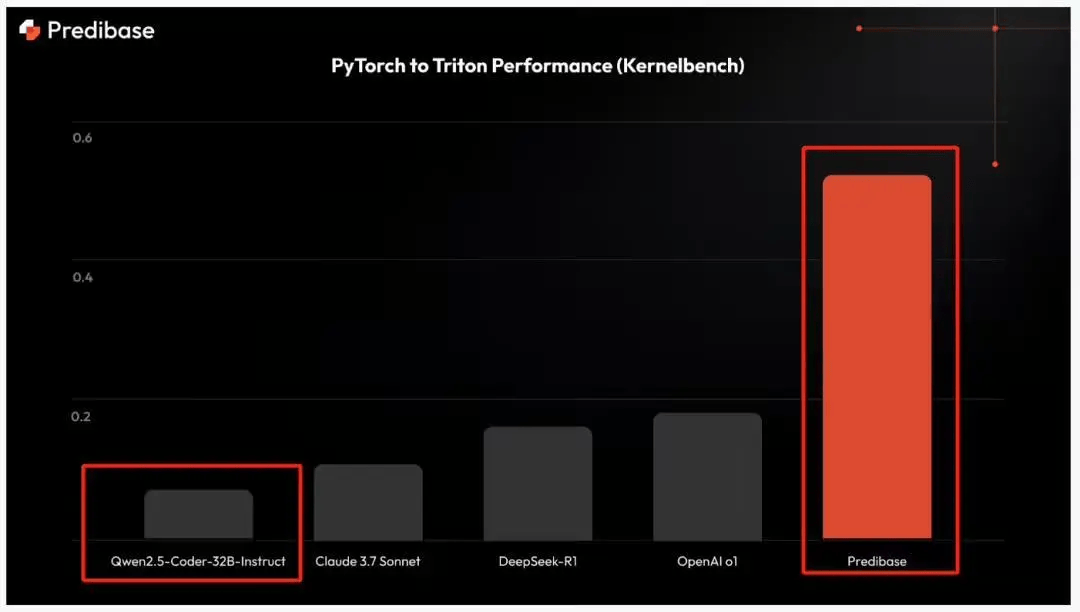

為了直觀展示RFT平臺的強大功能,Predibase團隊利用阿里開源的Qwen2.5-Coder-32B-instruct模型,微調(diào)出了一個專門用于將PyTorch代碼轉(zhuǎn)換為Triton格式的模型——Predibase-T2T-32B-RFT。這一成果進一步證明了RFT平臺在優(yōu)化模型行為和提高下游任務(wù)質(zhì)量方面的顯著優(yōu)勢。

Predibase-T2T-32B-RFT模型通過RFT平臺以交互方式調(diào)整行為,僅需極少的標記數(shù)據(jù)即可實現(xiàn)任務(wù)優(yōu)化。這一特性使其成為了專有大型語言模型(LLM)的高性價比、高性能替代方案。在訓(xùn)練過程中,RFT結(jié)合了冷啟動監(jiān)督式微調(diào)、強化學習和課程學習等多種策略,即便是在標記數(shù)據(jù)點有限的情況下(僅使用了十幾個標記數(shù)據(jù)點),也能取得令人矚目的成果。

在Kernelbench數(shù)據(jù)集上的基準測試結(jié)果顯示,經(jīng)過強化學習的Qwen2.5-Coder-32B-instruct模型在正確率方面表現(xiàn)優(yōu)異,較DeepSeek-R1和OpenAI的o1模型高出3倍,更是遠超Claude 3.7 Sonnet模型4倍以上。值得注意的是,盡管Predibase的模型在體量上遠小于這三者,但其性能卻毫不遜色。

對于感興趣的開發(fā)者和研究人員而言,Predibase已經(jīng)將Predibase-T2T-32B-RFT模型開源,并提供了在線體驗平臺,以便更多人能夠親身感受RFT平臺的強大功能。

開源地址:https://huggingface.co/predibase/Predibase-T2T-32B-RFT

在線體驗地址:https://predibase.com/reinforcement-fine-tuning-playground