近日,字節跳動旗下的豆包大模型團隊對外公布了一項重大技術突破,他們研發出了一種名為UltraMem的全新稀疏模型架構。這一創新架構旨在解決當前混合專家(MoE)模型在推理過程中面臨的高昂訪存問題,為提升AI模型的推理速度和降低成本提供了新的解決方案。

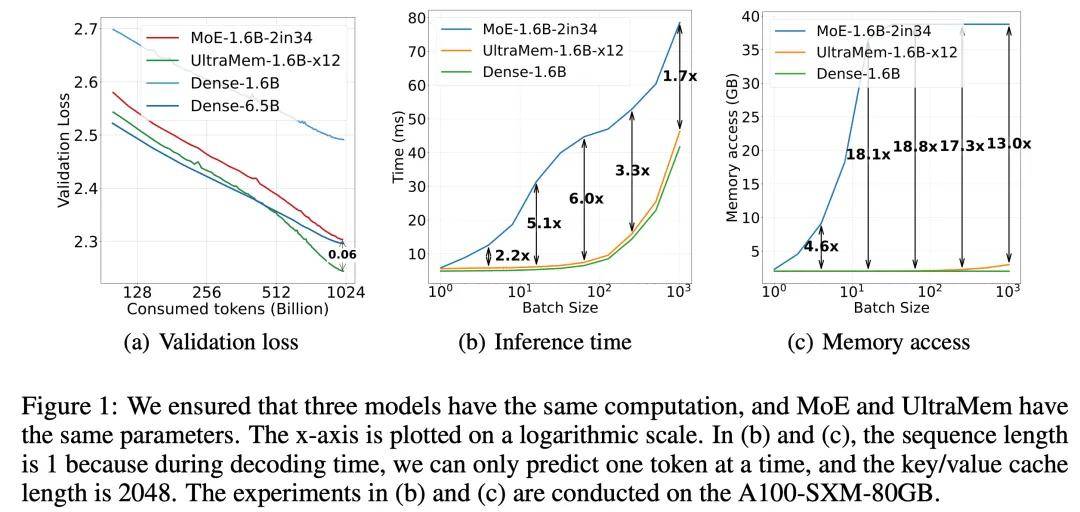

據悉,UltraMem架構通過獨特的設計,成功實現了計算與參數的解耦,從而在保持模型效果的同時,顯著降低了推理時的訪存需求。與傳統的MoE架構相比,UltraMem在推理速度上實現了2至6倍的提升,推理成本最高可降低83%。這一成果不僅彰顯了UltraMem在性能上的優勢,更為構建大規模AI模型開辟了全新的路徑。

實驗數據表明,當UltraMem模型的訓練規模達到2000萬value時,它在同等計算資源下展現出了業界領先的推理速度和模型性能。這一突破性的表現,預示著UltraMem在構建數十億規模value或expert的AI模型方面具有巨大的潛力。

UltraMem架構的核心優勢在于其高效的內存訪問機制。在參數和激活條件相同的情況下,UltraMem不僅超越了MoE模型在效果上的表現,還顯著提升了推理速度。在常見的batch size規模下,UltraMem的訪存成本幾乎與同計算量的Dense模型相當,這一特點使得UltraMem在實際應用中具有更高的性價比。

在Transformer架構的背景下,模型的性能往往與其參數數量和計算復雜度密切相關。然而,隨著大型語言模型(LLM)規模的不斷擴大,推理成本急劇增加,速度也隨之變慢。MoE架構雖然通過將計算和參數解耦在一定程度上緩解了這一問題,但在推理時仍面臨較小的batch size激活全部專家導致的訪存急劇上升和推理延遲大幅增加的挑戰。

UltraMem架構的推出,正是針對這一挑戰提出的解決方案。它不僅繼承了MoE架構在計算和參數解耦方面的優勢,還通過優化內存訪問機制,顯著降低了推理時的訪存成本和延遲。這一創新成果不僅為AI模型的發展注入了新的活力,也為未來AI技術的應用提供了更加高效、經濟的解決方案。