第1章 Azkaban概論

1.1 為什么需要工作流調度系統

1)一個完整的數據分析系統通常都是由大量任務單元組成:

Shell腳本程序,JAVA程序,MapReduce程序、Hive腳本等

2)各任務單元之間存在時間先后及前后依賴關系

3)為了很好地組織起這樣的復雜執行計劃,需要一個工作流調度系統來調度執行;

1.2 常見工作流調度系統

1)簡單的任務調度:直接使用linux的Crontab來定義;

2)復雜的任務調度:開發調度平臺或使用現成的開源調度系統,比如Ooize、Azkaban、 Airflow、DolphinScheduler等。

1.3 Azkaban與Oozie對比

對市面上最流行的兩種調度器,給出以下詳細對比,以供技術選型參考。總體來說,Ooize相比Azkaban是一個重量級的任務調度系統,功能全面,但配置使用也更復雜。如果可以不在意某些功能的缺失,輕量級調度器Azkaban是很不錯的候選對象。

第2章 Azkaban入門

2.1 集群模式安裝

2.1.1 上傳tar包

1)將azkaban-db-3.84.4.tar.gz,azkaban-exec-server-3.84.4.tar.gz,azkaban-web-server-3.84.4.tar.gz上傳到hadoop102的/opt/software路徑

[bigdata@hadoop102 software]$ ll

總用量 35572

-rw-r--r--. 1 bigdata bigdata 6433 4月 18 17:24 azkaban-db-3.84.4.tar.gz

-rw-r--r--. 1 bigdata bigdata 16175002 4月 18 17:26 azkaban-exec-server-3.84.4.tar.gz

-rw-r--r--. 1 bigdata bigdata 20239974 4月 18 17:26 azkaban-web-server-3.84.4.tar.gz

2)新建/opt/module/azkaban目錄,并將所有tar包解壓到這個目錄下

[bigdata@hadoop102 software]$ mkdir /opt/module/azkaban

3)解壓azkaban-db-3.84.4.tar.gz、 azkaban-exec-server-3.84.4.tar.gz和azkaban-web-server-3.84.4.tar.gz到/opt/module/azkaban目錄下

[bigdata@hadoop102 software]$ tar -zxvf azkaban-db-3.84.4.tar.gz -C /opt/module/azkaban/

[bigdata@hadoop102 software]$ tar -zxvf azkaban-exec-server-3.84.4.tar.gz -C /opt/module/azkaban/

[bigdata@hadoop102 software]$ tar -zxvf azkaban-web-server-3.84.4.tar.gz -C /opt/module/azkaban/

4)進入到/opt/module/azkaban目錄,依次修改名稱

[bigdata@hadoop102 azkaban]$ mv azkaban-exec-server-3.84.4/ azkaban-exec

[bigdata@hadoop102 azkaban]$ mv azkaban-web-server-3.84.4/ azkaban-web

2.1.2 配置MySQL

1)正常安裝MySQL

詳見《Hive安裝與配置》

2)啟動MySQL

[bigdata@hadoop102 azkaban]$ mysql -uroot -p000000

3)登陸MySQL,創建Azkaban數據庫

mysql> create database azkaban;

4)創建azkaban用戶并賦予權限

設置密碼有效長度4位及以上

mysql> set global validate_password_length=4;

設置密碼策略最低級別

mysql> set global validate_password_policy=0;

創建Azkaban用戶,任何主機都可以訪問Azkaban,密碼是000000

mysql> CREATE USER 'azkaban'@'%' IDENTIFIED BY '000000';

賦予Azkaban用戶增刪改查權限

mysql> GRANT SELECT,INSERT,UPDATE,DELETE ON azkaban.* to 'azkaban'@'%' WITH GRANT OPTION;

5)創建Azkaban表,完成后退出MySQL

mysql> use azkaban;

mysql> source /opt/module/azkaban/azkaban-db-3.84.4/create-all-sql-3.84.4.sql

mysql> quit;

6)更改MySQL包大小;防止Azkaban連接MySQL阻塞

[bigdata@hadoop102 software]$ sudo vim /etc/my.cnf

在[mysqld]下面加一行max_allowed_packet=1024M

[mysqld]

max_allowed_packet=1024M

8)重啟MySQL

[bigdata@hadoop102 software]$ sudo systemctl restart mysqld

2.1.3 配置Executor Server

Azkaban Executor Server處理工作流和作業的實際執行。

1)編輯azkaban.properties

[bigdata@hadoop102 azkaban]$ vim /opt/module/azkaban/azkaban-exec/conf/azkaban.properties

修改如下標紅的屬性

#...

default.timezone.id=Asia/Shanghai

#...

azkaban.webserver.url=http://hadoop102:8081

executor.port=12321

#...

database.type=mysql

mysql.port=3306

mysql.host=hadoop102

mysql.database=azkaban

mysql.user=azkaban

mysql.password=000000

mysql.numconnections=100

在最后添加

executor.metric.reports=true

executor.metric.milisecinterval.default=60000

2)同步azkaban-exec到所有節點

[bigdata@hadoop102 azkaban]$ xsync /opt/module/azkaban/azkaban-exec

3)必須進入到/opt/module/azkaban/azkaban-exec路徑,分別在三臺機器上,啟動executor server

[bigdata@hadoop102 azkaban-exec]$ bin/start-exec.sh

[bigdata@hadoop103 azkaban-exec]$ bin/start-exec.sh

[bigdata@hadoop104 azkaban-exec]$ bin/start-exec.sh

注意:如果在/opt/module/azkaban/azkaban-exec目錄下出現executor.port文件,說明啟動成功

4)下面激活executor,需要

[bigdata@hadoop102 azkaban-exec]$ curl -G "hadoop102:$(<./executor.port)/executor?action=activate" && echo

[bigdata@hadoop103 azkaban-exec]$ curl -G "hadoop103:$(<./executor.port)/executor?action=activate" && echo

[bigdata@hadoop104 azkaban-exec]$ curl -G "hadoop104:$(<./executor.port)/executor?action=activate" && echo

如果三臺機器都出現如下提示,則表示激活成功

{"status":"success"}

2.1.4 配置Web Server

Azkaban Web Server處理項目管理,身份驗證,計劃和執行觸發。

1)編輯azkaban.properties

[bigdata@hadoop102 azkaban]$ vim /opt/module/azkaban/azkaban-web/conf/azkaban.properties

修改如下屬性

...

default.timezone.id=Asia/Shanghai

...

database.type=mysql

mysql.port=3306

mysql.host=hadoop102

mysql.database=azkaban

mysql.user=azkaban

mysql.password=000000

mysql.numconnections=100

...

azkaban.executorselector.filters=StaticRemainingFlowSize,CpuStatus

說明:

#StaticRemainingFlowSize:正在排隊的任務數;

#CpuStatus:CPU占用情況

#MinimumFreeMemory:內存占用情況。測試環境,必須將MinimumFreeMemory刪除掉,否則它會認為集群資源不夠,不執行。

2)修改azkaban-users.xml文件,添加bigdata用戶

[bigdata@hadoop102 azkaban-web]$ vim /opt/module/azkaban/azkaban-web/conf/azkaban-users.xml

<azkaban-users>

<user groups="azkaban" password="azkaban" roles="admin" username="azkaban"/>

<user password="metrics" roles="metrics" username="metrics"/>

<user password="bigdata" roles="metrics,admin" username="bigdata"/>

<role name="admin" permissions="ADMIN"/>

<role name="metrics" permissions="METRICS"/>

</azkaban-users>

3)必須進入到hadoop102的/opt/module/azkaban/azkaban-web路徑,啟動web server

[bigdata@hadoop102 azkaban-web]$ bin/start-web.sh

4)訪問http://hadoop102:8081,并用bigdata用戶登陸

2.2 Work Flow案例實操

2.2.1 HelloWorld案例

1)在windows環境,新建azkaban.project文件,編輯內容如下

azkaban-flow-version: 2.0

注意:該文件作用,是采用新的Flow-API方式解析flow文件。

2)新建basic.flow文件,內容如下

nodes:

- name: jobA

type: command

config:

command: echo "Hello World"

(1)Name:job名稱

(2)Type:job類型。command表示你要執行作業的方式為命令

(3)Config:job配置

3)將azkaban.project、basic.flow文件壓縮到一個zip文件,文件名稱必須是英文。

4)在WebServer新建項目:http://hadoop102:8081/index

5)給項目名稱命名和添加項目描述

6)first.zip文件上傳

7)選擇上傳的文件

8)執行任務流

9)在日志中,查看運行結果

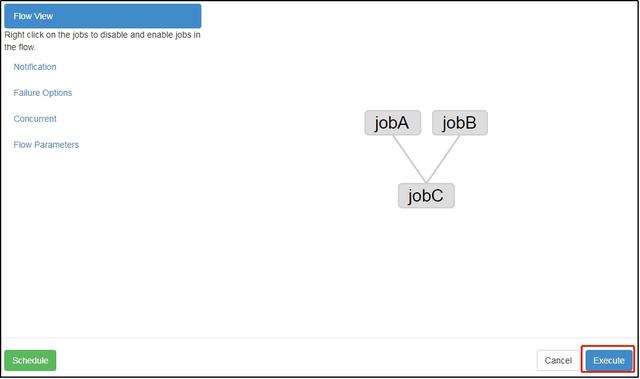

2.2.2 作業依賴案例

需求:JobA和JobB執行完了,才能執行JobC

具體步驟:

1)修改basic.flow為如下內容

nodes:

- name: jobC

type: command

# jobC 依賴 JobA和JobB

dependsOn:

- jobA

- jobB

config:

command: echo "I’m JobC"

- name: jobA

type: command

config:

command: echo "I’m JobA"

- name: jobB

type: command

config:

command: echo "I’m JobB"

(1)dependsOn:作業依賴,后面案例中演示

2)將修改后的basic.flow和azkaban.project壓縮成second.zip文件

3)重復2.3.1節HelloWorld后續步驟。

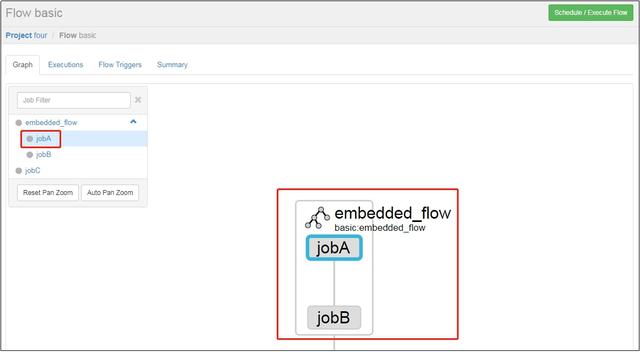

2.2.3 內嵌工作流案例

需求:JobA執行完后執行JobB,JobA和JobB形成一個工作流embedded_flow;JobC依賴于embedded_flow該工作流。

1)工作流定義文件中可以添加子工作流,例如:

nodes:

- name: jobC

type: command

# jobC 依賴embedded_flow

dependsOn:

- embedded_flow

config:

command: echo "I’m JobC"

- name: embedded_flow

type: flow

nodes:

- name: jobB

type: noop

dependsOn:

- jobA

- name: jobA

type: command

config:

command: pwd

參數說明:

type: 作業類型。flow表示,定義為工作流類型

type: noop 什么也不處理

2)將修改后的basic.flow和azkaban.project壓縮成three.zip文件

3)重復2.3.1節HelloWorld后續步驟。

2.2.4 自動失敗重試案例

需求:如果執行任務失敗,需要重試3次,重試的時間間隔10000ms

具體步驟:

1)編譯配置流

nodes:

- name: JobA

type: command

config:

command: sh /not_exists.sh

retries: 3

retry.backoff: 10000

參數說明:

retries:重試次數

retry.backoff:重試的時間間隔

2)將修改后的basic.flow和azkaban.project壓縮成four.zip文件

3)重復2.3.1節HelloWorld后續步驟。

4)執行并觀察到一次失敗+三次重試

5)也可以點擊上圖中的Log,在任務日志中看到,總共執行了4次。

6)也可以在Flow全局配置中添加任務失敗重試配置,此時重試配置會應用到所有Job。

案例如下:

config:

retries: 3

retry.backoff: 10000

nodes:

- name: JobA

type: command

config:

command: sh /not_exists.sh

2.2.5 手動失敗重試案例

需求:JobA=》JobB(依賴于A)=》JobC=》JobD=》JobE=》JobF。生產環境,任何Job都有可能掛掉,可以根據需求執行想要執行的Job。

具體步驟:

1)編譯配置流

nodes:

- name: JobA

type: command

config:

command: echo "This is JobA."

- name: JobB

type: command

dependsOn:

- JobA

config:

command: echo "This is JobB."

- name: JobC

type: command

dependsOn:

- JobB

config:

command: echo "This is JobC."

- name: JobD

type: command

dependsOn:

- JobC

config:

command: echo "This is JobD."

- name: JobE

type: command

dependsOn:

- JobD

config:

command: echo "This is JobE."

- name: JobF

type: command

dependsOn:

- JobE

config:

command: echo "This is JobF."

2)將修改后的basic.flow和azkaban.project壓縮成five.zip文件

3)重復2.3.1節HelloWorld后續步驟。

Enable和Disable下面都分別有如下參數:

Parents:該作業的上一個任務

Ancestors:該作業前的所有任務

Children:該作業后的一個任務

Descendents:該作業后的所有任務

Enable All:所有的任務

4)可以根據需求選擇性執行對應的任務。