自去年11月ChatGPT上線以來(lái),以前所未有的速度屢次刷新App用戶增速之余,“大模型”也開始進(jìn)入人們的視野,乘上了發(fā)展東風(fēng),迅速成為科技圈的新寵。然而作為旁觀者,在圍觀吃瓜的同時(shí)想必也會(huì)有疑惑,“大模型”究竟是什么,它為何如此神奇,AI 2.0時(shí)代真的能靠大模型開啟嗎?

一、何為大模型

2021年8月,知名AI科學(xué)家,斯坦福大學(xué)首位紅杉講席教授李飛飛,與其他上百位AI科學(xué)家,聯(lián)名發(fā)表了一份研究報(bào)告《On the Opportunities and Risk of Foundation Models》,中文譯名《基礎(chǔ)模型的風(fēng)險(xiǎn)與機(jī)遇》,是學(xué)界對(duì)大模型的首次正式研究。而根據(jù)另一位知名的AI科學(xué)家,斯蒂芬·沃爾夫勒姆(Stephen Wolfram)的觀點(diǎn),模型是“一種將數(shù)據(jù)映射到可用信息上的工具,是我們用來(lái)探索和理解世界的一種方式。”

在機(jī)器學(xué)習(xí)和AI等領(lǐng)域,“模型”通常是指一種數(shù)學(xué)模型或計(jì)算模型,它可以從海量數(shù)據(jù)中學(xué)習(xí)出一些隱藏其中的模式或規(guī)律,進(jìn)而對(duì)未來(lái)的數(shù)據(jù)進(jìn)行預(yù)測(cè),或生成新數(shù)據(jù)。現(xiàn)在常說(shuō)的大模型之大,一般指內(nèi)置的參數(shù)量數(shù)量級(jí)之大,比如GPT-3.5的1750億參數(shù)。目前大火的,各種各樣的類GPT產(chǎn)品屬于大語(yǔ)言模型(Large Language Models,簡(jiǎn)稱LLM)。之所以能以前所未有的速度火遍全球,除了歸功于科技發(fā)展,還有個(gè)經(jīng)常被有意無(wú)意忽視的原因在于,語(yǔ)言作為信息的載體之一主要依賴文字,而AI對(duì)文字的學(xué)習(xí)和處理能力相對(duì)簡(jiǎn)單,特別是以英語(yǔ)為主的型和語(yǔ)言,且發(fā)展時(shí)間也由來(lái)已久。1954年1月7日,美國(guó)喬治城大學(xué)進(jìn)行的“喬治城-IBM實(shí)驗(yàn)”,成功將約六十句俄語(yǔ)自動(dòng)翻譯成英語(yǔ),被后世視為AI介入語(yǔ)言處理與翻譯的開端。雖然這次實(shí)驗(yàn)在幾年后被人發(fā)現(xiàn)有失公允,但時(shí)代的潮流一旦開啟就不會(huì)說(shuō)停就停。

與大語(yǔ)言模型類似的,Midjourney,DALL-E等處理文生圖的模型,通常是一個(gè)語(yǔ)言模型,負(fù)責(zé)將輸入的文本轉(zhuǎn)化為機(jī)器語(yǔ)言,再結(jié)合一個(gè)圖像生成模型,負(fù)責(zé)生成圖像,即目前各家企業(yè)常說(shuō)的“跨模態(tài)模型”。類似的還有文生視頻模型,這需要更強(qiáng)大的算力與更復(fù)雜的算法。

二、從AI到大模型

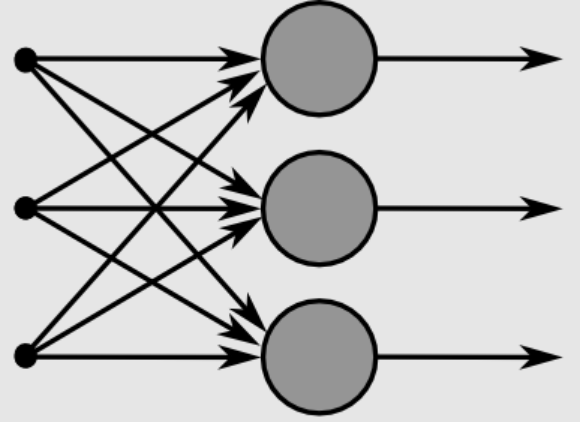

上世紀(jì)中葉,AI開始發(fā)展時(shí)有三種流派,其中之一為“聯(lián)結(jié)主義”。這派觀點(diǎn)認(rèn)為實(shí)現(xiàn)AI的關(guān)鍵在于模仿人腦的神經(jīng)元等結(jié)構(gòu),逐漸發(fā)展為現(xiàn)在常見的人工神經(jīng)網(wǎng)絡(luò)模型。從這個(gè)角度來(lái)說(shuō),大模型的出現(xiàn)并非偶然,而且人工神經(jīng)網(wǎng)絡(luò)在大模型中的運(yùn)用非常普遍,二者有相互促進(jìn),共同發(fā)展的趨勢(shì)。

人類的智能活動(dòng)非常復(fù)雜,以語(yǔ)言為例,其中涉及到大量的知識(shí)和推理。比如閱讀文章時(shí)需要理解語(yǔ)句,識(shí)別其中的語(yǔ)法和語(yǔ)義,推斷其中的邏輯關(guān)系,并將這些信息組合起來(lái),最終形成整篇文章的意義。同樣的,當(dāng)進(jìn)行對(duì)話時(shí)就需要理解對(duì)方的意圖和情感,并在此基礎(chǔ)上進(jìn)行回應(yīng)。大語(yǔ)言模型可以通過(guò)學(xué)習(xí)海量的文本數(shù)據(jù),來(lái)模擬這些復(fù)雜的處理和推理過(guò)程,從而對(duì)這些任務(wù)進(jìn)行建模和解決。這不僅有助于改進(jìn)現(xiàn)有的自然語(yǔ)言處理(NLP)技術(shù),還可以提供新的工具,用于更深入地理解和使用自然語(yǔ)言。通過(guò)發(fā)展AI來(lái)探索和了解人類智能的本質(zhì),這也是AI的初衷之一。

上文提到的研究報(bào)告《基礎(chǔ)模型的風(fēng)險(xiǎn)與機(jī)遇》,其中也指出大模型將發(fā)展出“涌現(xiàn)”和“同質(zhì)化”的特性。其中“涌現(xiàn)”代表某種系統(tǒng)行為是隱性推動(dòng)的,而非顯式構(gòu)建的。對(duì)此,有個(gè)生活中常見的例子可以幫助理解:新生兒學(xué)會(huì)說(shuō)話基本都是在一歲至一歲半,盡管很多時(shí)候都是不明所以的單字詞。這種現(xiàn)象就可以視為人類語(yǔ)言能力的“涌現(xiàn)”。“同質(zhì)化”則指模型的基本能力是智能表現(xiàn)的關(guān)鍵所在,任何一點(diǎn)改進(jìn)都可能會(huì)迅速影響到同類型產(chǎn)品,但缺陷也可能會(huì)被下游模型或產(chǎn)品繼承。回看最近半年多的發(fā)展,看看目前各家企業(yè)推出的大模型產(chǎn)品,不由得感慨李飛飛等人的先見之明。2017年,谷歌大腦推出Transformer模型,使深度學(xué)習(xí)模型的參數(shù)量突破了一億的門檻,隨后的BERT,GPT等大模型,都在鉚足了勁加大參數(shù)量,GPT-3突破百億,GPT-3.5的1750億參數(shù)量都是其中代表。

要讓大模型實(shí)現(xiàn)“涌現(xiàn)”能力,加大參數(shù)量似乎是唯一可行的辦法,但質(zhì)疑聲也始終不絕于耳,比較有代表性的有“大參數(shù)能帶來(lái)真正的智能嗎?”“一本正經(jīng)的胡說(shuō)八道該如何改進(jìn)?”“AI給出的醫(yī)療建議如何做到對(duì)癥下藥?”等等。不可否認(rèn)的,大模型做到了早期預(yù)訓(xùn)練模型做不到或做不好的事情,比如過(guò)去NLP中的文字生成、文本理解、自動(dòng)問(wèn)答等下游任務(wù)。大語(yǔ)言模型不僅生成的文本更加流暢,內(nèi)容的真實(shí)性也有了顯著改善。當(dāng)然,大模型最終能否走向“通用人工智能”(AGI)仍然不確定,只是目前來(lái)看,大模型的確有希望引領(lǐng)下一個(gè)重量級(jí)的AI賽道。

三、大模型的用途

雖然深度學(xué)習(xí)使很多通用領(lǐng)域的精度和效率得到很大改善,但是AI大模型目前仍有許多問(wèn)題,最明顯的莫過(guò)于模型的通用性不高,即大模型往往只能用于特定領(lǐng)域,應(yīng)用到其他領(lǐng)域時(shí)即露餡成“人工智障”。即便如此,大模型依然大有用途。

1.模型碎片化,大模型提供預(yù)訓(xùn)練方案

目前AI面對(duì)的不同行業(yè)與業(yè)務(wù)場(chǎng)景非常繁雜,相關(guān)需求也呈現(xiàn)碎片化、多樣化的特點(diǎn)。從開發(fā)、微調(diào)、優(yōu)化、迭代到應(yīng)用,大模型的研發(fā)成本極高,且難以滿足特定需求,因此有人說(shuō)現(xiàn)階段的大模型研發(fā)更像是小作坊里的手動(dòng)加工式產(chǎn)品。一家企業(yè)想要用AI賦能自身的業(yè)務(wù),可能還要額外招聘懂AI的技術(shù)人員。對(duì)此困境,大模型可以提供一種解決方案,即“預(yù)訓(xùn)練大模型+下游任務(wù)微調(diào)”。大規(guī)模在預(yù)訓(xùn)練階段即可有效地從海量數(shù)據(jù)中獲得知識(shí),通過(guò)預(yù)置大量參數(shù)并針對(duì)特定任務(wù)加以微調(diào),極大地?cái)U(kuò)展了大模型的通用能力。例如在NLP領(lǐng)域,大模型通過(guò)預(yù)訓(xùn)練任務(wù)和部分下游任務(wù)的參數(shù),在一定程度上解決了通用性的難題,可以被應(yīng)用于翻譯,問(wèn)答,文本生成等自然語(yǔ)言任務(wù),ChatGPT的能說(shuō)會(huì)道也在很大程度上得益于此。

2.大模型具備自監(jiān)督學(xué)習(xí)功能,降低訓(xùn)練研發(fā)成本

大模型的自監(jiān)督學(xué)習(xí)方法可以減少數(shù)據(jù)標(biāo)注,這在一定程度上解決了人工標(biāo)注成本高、周期長(zhǎng)、準(zhǔn)確度不高的問(wèn)題。由于節(jié)約了數(shù)據(jù)標(biāo)準(zhǔn)的成本,使得小樣本的學(xué)習(xí)也能達(dá)到比以前更好的能力,并且模型參數(shù)規(guī)模越大,優(yōu)勢(shì)越明顯,避免開發(fā)人員再進(jìn)行大規(guī)模的訓(xùn)練,使用小樣本就可以訓(xùn)練自己所需模型,極大降低開發(fā)與使用成本。數(shù)據(jù)標(biāo)注依賴的人工成本非常高,而在移動(dòng)互聯(lián)網(wǎng)觸手可及的時(shí)代,大量的未標(biāo)注數(shù)據(jù)很容易獲得。

3.大模型可能突破現(xiàn)有模型結(jié)構(gòu)的精度局限

機(jī)器學(xué)習(xí),深度學(xué)習(xí)發(fā)展早期的歷程,乃至AI 1.0時(shí)代的發(fā)展歷程,模型精度的提升主要依賴網(wǎng)絡(luò)結(jié)構(gòu)的發(fā)展與變革。但是,隨著人工神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)技術(shù)的逐漸成熟,且收效也趨于收斂,還想通過(guò)優(yōu)化神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)從而打破精度局限也將日益困難。谷歌2021年發(fā)布的視覺遷移模型Big Transfer,擴(kuò)大數(shù)據(jù)規(guī)模即可提升大模型結(jié)構(gòu)的精度,使用ILSVRC-2012(128萬(wàn)張圖片,1000個(gè)類別)和JFT-300M(3億張圖片,1829個(gè)類別)兩個(gè)數(shù)據(jù)集來(lái)訓(xùn)練Re.NET50大模型,精度分別是77%和79%。另外使用JFT-300M訓(xùn)練ResNet152x4,精度則上升到87.5%。

前面提到的,語(yǔ)言作為信息的載體之一,AI處理起來(lái)相對(duì)容易,也因此目前大模型主要是以大語(yǔ)言模型為主。ChatGPT拋棄了“循環(huán)神經(jīng)網(wǎng)絡(luò)”(RNN)序列依賴的問(wèn)題,采用了“注意力機(jī)制”的Transformer結(jié)構(gòu),使得類GPT的NLP能夠在短時(shí)間內(nèi)即演變出相當(dāng)多的大模型,國(guó)內(nèi)各家企業(yè)能在最近幾個(gè)月內(nèi)爭(zhēng)相發(fā)布自己的大模型,這也是個(gè)不能忽視的原因。雖然不能保證AI 2.0時(shí)代真的就由此開啟,但至少可以讓我們對(duì)未來(lái)有驚鴻一瞥。