編輯:陳萍、杜偉

研究者希望這篇文章對(duì)神經(jīng)網(wǎng)絡(luò)架構(gòu)感興趣的人有所幫助,特別是那些正在尋找不同角度進(jìn)行研究的研究者。

深度學(xué)習(xí)的基本原理可以追溯到幾十年前,20 世紀(jì) 80 年代 Geoffrey Hinton 等人提出了基于梯度的反向傳播學(xué)習(xí)算法,而 Con.NETs 從早期就被應(yīng)用于手寫(xiě)數(shù)字識(shí)別等計(jì)算機(jī)視覺(jué)任務(wù)。然而,深度學(xué)習(xí)的真正威力直到 2012 年才顯露出來(lái),那年 AlexNet 贏得了 ImageNet 大規(guī)模圖像分類挑戰(zhàn)賽。

之后數(shù)據(jù)可用性的提高、計(jì)算技術(shù)的進(jìn)步和算法的改進(jìn)使得深度學(xué)習(xí)持續(xù)取得成功。隨著最近大型模型的興起,這一領(lǐng)域的快速發(fā)展還沒(méi)有顯示出放緩的跡象。

深度學(xué)習(xí)不僅對(duì)我們的日常生活產(chǎn)生了顯著的影響,還改變了機(jī)器學(xué)習(xí)從業(yè)者和研究人員的工作流程。新的設(shè)計(jì)原則不斷被提出,例如 ResNet 引入殘差連接、 Transformers 采用多頭自注意力等。在算法不斷發(fā)展的過(guò)程中,效率和可擴(kuò)展性是兩個(gè)不能忽視的概念,讓視覺(jué)模型變得既小又大又成為另一需求。

怎樣理解既小又大呢?小模型代表對(duì)效率的需求,因?yàn)橐曈X(jué)識(shí)別系統(tǒng)通常部署在邊緣設(shè)備上;大型模型突出對(duì)可擴(kuò)展性的需求,其可以利用日益豐富的計(jì)算和數(shù)據(jù)來(lái)實(shí)現(xiàn)更高的準(zhǔn)確率。最近幾年這兩個(gè)方向的研究都取得了卓越成效,產(chǎn)生了許多有用的設(shè)計(jì)原則被后來(lái)的研究所采用。

本文中,來(lái)自 UC 伯克利的博士生劉壯(Zhuang Liu)在其博士論文《 Efficient and Scalable Neural Architectures for Visual Recognition 》中,從兩個(gè)方面展開(kāi)研究:(1)開(kāi)發(fā)直觀的算法以實(shí)現(xiàn)高效靈活的 ConvNet 模型推理;(2) 研究基線方法以揭示擴(kuò)展方法成功的原因。

具體而言,首先,本文介紹了關(guān)于密集預(yù)測(cè)的第一個(gè)隨時(shí)算法研究。然后,該研究將模型剪枝算法與簡(jiǎn)單的基線方法進(jìn)行比較來(lái)檢查模型的有效性。最后研究者提出了這樣一個(gè)問(wèn)題,即通過(guò)采用 Transformer 中的設(shè)計(jì)技巧對(duì)傳統(tǒng)的 ConvNet 進(jìn)行現(xiàn)代化改造,來(lái)測(cè)試純 ConvNet 所能達(dá)到的極限,并探索在視覺(jué)任務(wù)上自注意力機(jī)制在 Transformer 中的可擴(kuò)展性上所起的作用。

論文地址:https://www2.eecs.berkeley.edu/Pubs/TechRpts/2022/EECS-2022-205.pdf

本文除了提出一個(gè)新架構(gòu)外,該研究還從批判的角度對(duì)被認(rèn)為是微不足道或老式基線的方法或模型進(jìn)行實(shí)證研究,發(fā)現(xiàn)當(dāng)提供正確的技術(shù)時(shí),它們具有驚人的競(jìng)爭(zhēng)力。

劉壯(Zhuang Liu)現(xiàn)在是 UC 伯克利 EECS(電氣工程與計(jì)算機(jī)科學(xué)) 的博士生,由 Trevor Darrell 教授指導(dǎo)。此外,他還在 Meta AI Research(原 Facebook AI Research )擔(dān)任兼職學(xué)生研究員。也曾在康奈爾大學(xué)、英特爾實(shí)驗(yàn)室和 Adobe Research 擔(dān)任訪問(wèn)研究員或?qū)嵙?xí)生。他于 2017 年在清華大學(xué)姚班獲得學(xué)士學(xué)位。

劉壯的研究重點(diǎn)是準(zhǔn)確和高效的深度學(xué)習(xí)架構(gòu) / 方法,他對(duì)開(kāi)發(fā)簡(jiǎn)單的方法和研究基線方法特別感興趣。他還是大名鼎鼎 DenseNet 的共同一作,憑借論文《Densely Connected Convolutional Networks》,摘得 CVPR 2017 最佳論文獎(jiǎng)。

章節(jié)內(nèi)容簡(jiǎn)介

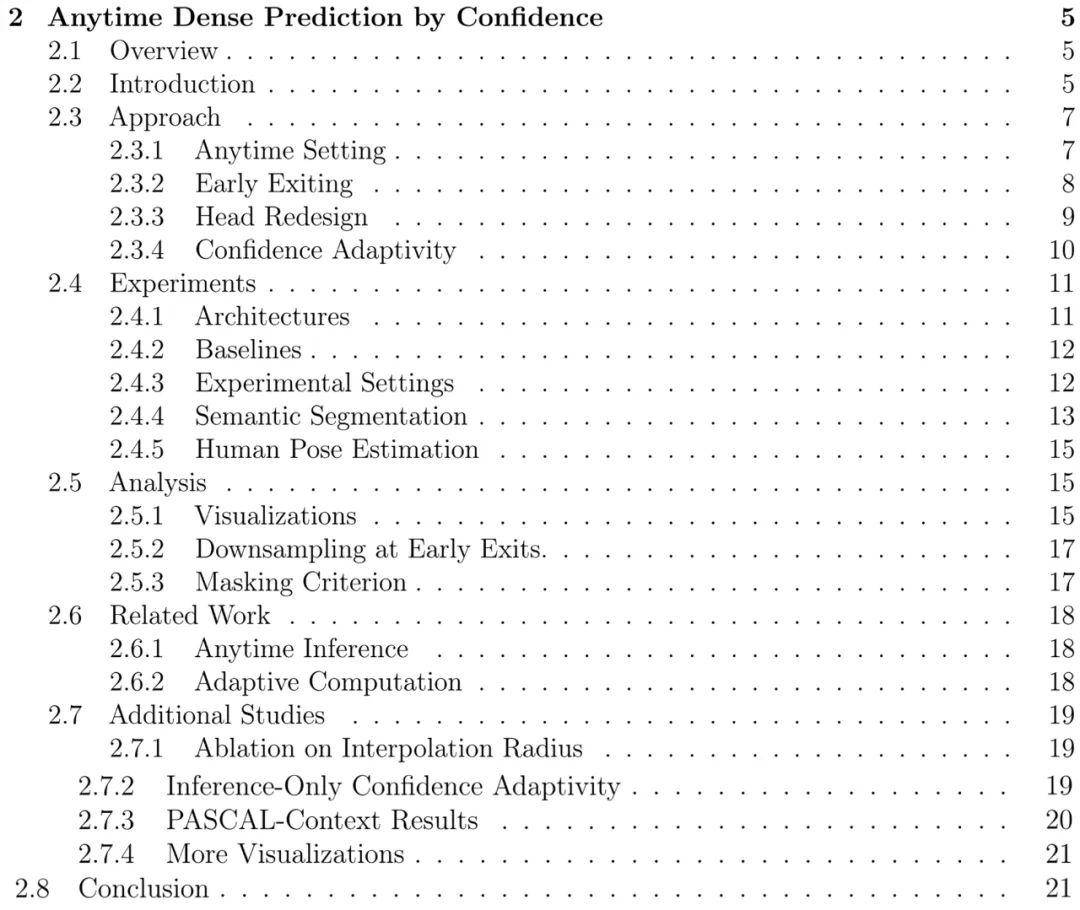

第二章:基于置信的隨時(shí)密集預(yù)測(cè)

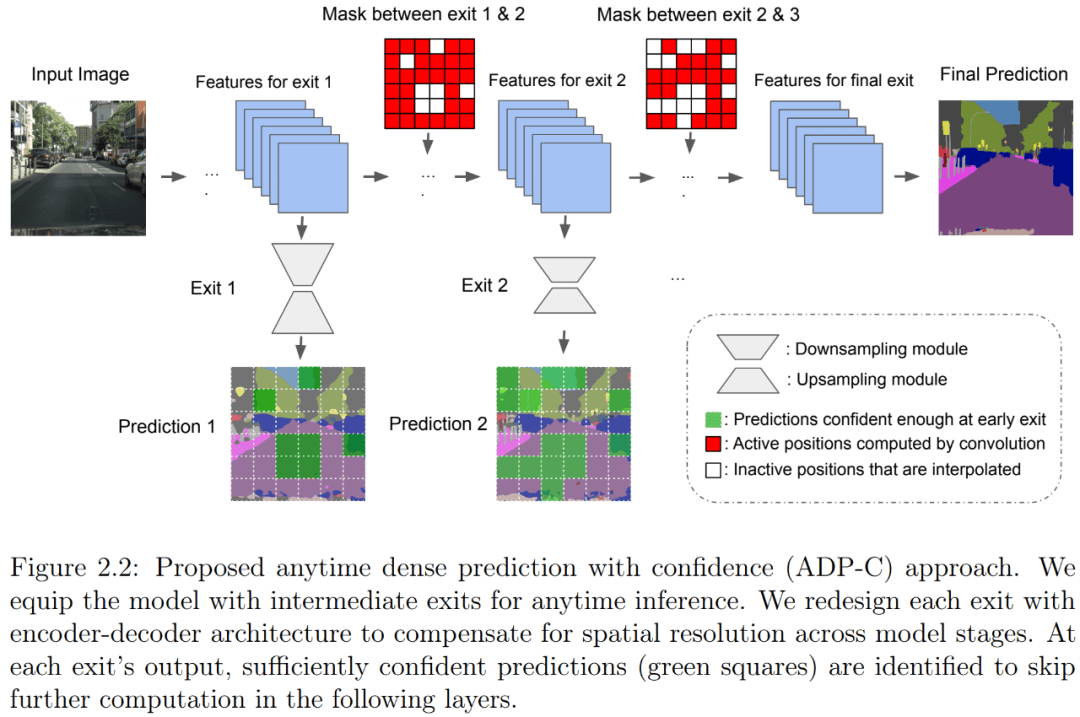

本文介紹了一種隨時(shí)密集視覺(jué)識(shí)別方法,它可以讓神經(jīng)網(wǎng)絡(luò)推理更加靈活。隨時(shí)推理需要一個(gè)模型對(duì)隨時(shí)可能的停止進(jìn)行一系列預(yù)測(cè)。先前關(guān)于隨時(shí)視覺(jué)識(shí)別的研究主要集中在圖像分類領(lǐng)域。作者提出了首個(gè)用于隨時(shí)密集預(yù)測(cè)的統(tǒng)一和端到端方法。一連串的 exit 被附加到模型上以進(jìn)行多個(gè)預(yù)測(cè)。作者重新設(shè)計(jì)了 exit,以考慮每個(gè) exit 的特征的深度和空間分辨率。

為了減少總計(jì)算量并充分利用先前預(yù)測(cè),作者開(kāi)發(fā)了一種全新的空間自適應(yīng)方法,以避免在早期預(yù)測(cè)已經(jīng)足夠置信的區(qū)域上進(jìn)行進(jìn)一步計(jì)算。這一方法被命名為基于置信的隨時(shí)密集預(yù)測(cè)(anytime dense prediction with confidence, ADP-C),它達(dá)到了與基礎(chǔ)模型相同的最終準(zhǔn)確率水平,同時(shí)顯著減少了總計(jì)算量。

ADP-C 方法概覽。

作者在 Cityscapes 語(yǔ)義分割和 MPII 人體姿態(tài)估計(jì)數(shù)據(jù)集上評(píng)估了所提方法,結(jié)果表明,ADP-C 可以在不犧牲準(zhǔn)確率的情況下隨時(shí)進(jìn)行推理,同時(shí)還將基礎(chǔ)模型的總 FLOPs 減少 44.4% 和 59.1%。作者還與基于深度平衡網(wǎng)絡(luò)和基于特征的隨機(jī)采樣進(jìn)行的隨時(shí)推理進(jìn)行比較,表明 ADP-C 在準(zhǔn)確率 - 計(jì)算曲線上始終占有優(yōu)勢(shì)。

本章目錄如下:

第三章:重新思考網(wǎng)絡(luò)剪枝的價(jià)值

與上章中的自適應(yīng)計(jì)算隨時(shí)推理方法相比,靜態(tài)神經(jīng)網(wǎng)絡(luò)剪枝方法試圖通過(guò)與輸入無(wú)關(guān)的方式減少神經(jīng)網(wǎng)絡(luò)的計(jì)算量。由于自身具有的簡(jiǎn)單性、有效性以及有時(shí)更好的硬件兼容性,這類方法通常在實(shí)踐中用于縮小模型。在本章中,作者試圖了解靜態(tài)神經(jīng)網(wǎng)絡(luò)剪枝方法成功背后的底層機(jī)制。

典型的剪枝算法是一個(gè)三段式的 pipeline,分別為訓(xùn)練(大模型)、剪枝和微調(diào)。在剪枝過(guò)程中,根據(jù)一定的標(biāo)準(zhǔn)對(duì)冗余權(quán)重進(jìn)行剪枝,并保留重要的權(quán)重,以保持最佳準(zhǔn)確率。在這項(xiàng)工作中,作者提出了一些與常見(jiàn)看法相悖的觀察結(jié)果。對(duì)于其檢查過(guò)的所有 SOTA 結(jié)構(gòu)化修剪算法,對(duì)修剪后的模型進(jìn)行微調(diào)只能得到與使用隨機(jī)初始化權(quán)重訓(xùn)練模型相當(dāng)或更差的性能。對(duì)于假設(shè)預(yù)定義目標(biāo)網(wǎng)絡(luò)架構(gòu)的剪枝算法,則可以擺脫整個(gè) pipeline 并直接從頭開(kāi)始訓(xùn)練目標(biāo)網(wǎng)絡(luò)。

作者的觀察結(jié)果對(duì)于多個(gè)網(wǎng)絡(luò)架構(gòu)、數(shù)據(jù)集和任務(wù)是一致的,這意味著:1)通常不需要訓(xùn)練大型、過(guò)度參數(shù)化的模型來(lái)獲得高效的最終模型;2)學(xué)得的大模型的「重要」權(quán)重通常對(duì)小型剪枝模型沒(méi)有用處;3)對(duì)最終模型的效率更關(guān)鍵的是剪枝后的架構(gòu)本身,而非一組繼承的「重要」權(quán)重。這表明在某些情況下,剪枝可能作為架構(gòu)搜索范式產(chǎn)生作用。

結(jié)果表明,未來(lái)結(jié)構(gòu)化剪枝方法的研究中需要進(jìn)行更仔細(xì)的基線評(píng)估。作者還與「彩票假設(shè)」(Lottery Ticket Hypothesis)進(jìn)行了比較,發(fā)現(xiàn)在最佳學(xué)習(xí)率下,彩票假設(shè)中使用的「中獎(jiǎng)彩票」初始化并沒(méi)有帶來(lái)隨機(jī)初始化的改進(jìn)。

本章目錄如下:

第四章:A ConvNet for the 2020s

剪枝是一種流行的縮小模型的方法。在上章中,作者通過(guò)實(shí)證研究證明了結(jié)構(gòu)化剪枝的真正價(jià)值不是獲得一組特定的權(quán)重值,而是識(shí)別出一個(gè)有用的子架構(gòu)。在本章中,作者將注意力轉(zhuǎn)向擴(kuò)展計(jì)算機(jī)視覺(jué)神經(jīng)架構(gòu)。

一個(gè)經(jīng)典的例子是 ResNets,它提出了殘差連接。將沒(méi)有殘差連接的「普通」網(wǎng)絡(luò)擴(kuò)展到數(shù)十層會(huì)導(dǎo)致訓(xùn)練損失增加,更不用說(shuō)測(cè)試準(zhǔn)確率變差了。然而,一個(gè)具有殘差連接的 ResNet 可以擴(kuò)展到 100 多層,同時(shí)改進(jìn)了訓(xùn)練損失和測(cè)試準(zhǔn)確率。之后,Vision Transformers 開(kāi)始顯現(xiàn)出比基于卷積的 ResNet 更大的可擴(kuò)展性。作者試圖通過(guò)與現(xiàn)代化 ConvNet 的比較,來(lái)了解 Transformers 擴(kuò)展成功的背后是什么。

作者重新檢查了設(shè)計(jì)空間并測(cè)試了純 ConvNet 所能達(dá)到的極限,并逐漸將標(biāo)準(zhǔn) ResNet「升級(jí)(modernize」為視覺(jué) Transformer 的設(shè)計(jì),在過(guò)程中發(fā)現(xiàn)了導(dǎo)致性能差異的幾個(gè)關(guān)鍵組件。作者將一系列純 ConvNet 模型命名為 ConvNeXt。ConvNeXt 完全由標(biāo)準(zhǔn) ConvNet 模塊構(gòu)建,并且在準(zhǔn)確率和可擴(kuò)展性方面,ConvNeXt 取得了媲美 Transformer 的結(jié)果,達(dá)到 87.8% ImageNet top-1 準(zhǔn)確率,在 COCO 檢測(cè)和 ADE20K 分割方面優(yōu)于 Swin Transformer,同時(shí)保持標(biāo)準(zhǔn) ConvNet 的簡(jiǎn)單性和有效性。

本章目錄如下:

更多詳細(xì)內(nèi)容請(qǐng)參閱原論文。