算法算法

從1950年代的早期研究開始,機器學習的所有工作似乎都隨著神經網絡的創建而積累起來。 從邏輯回歸到支持向量機,相繼提出了新算法之后的算法,但是從字面上看,神經網絡是算法算法和機器學習的頂峰。 它是什么是機器學習的普遍概括,而不是一種嘗試。

從這個意義上講,它不僅僅是一個算法,而不僅僅是一個框架和一個概念,考慮到構建神經網絡的大量自由性,這是顯而易見的-隱藏層和節點數,激活函數,優化器,損失函數,網絡類型( 卷積,遞歸等)和專用層(批處理規范,輟學等),僅舉幾例。

從這個角度來看,神經網絡是一個概念,而不是一個嚴格的算法,這帶來了一個非常有趣的推論:任何機器學習算法,無論是決策樹還是k近鄰,都可以使用神經網絡來表示。 雖然本能地通過幾個示例可以理解,但是該陳述可以在數學上得到證明。

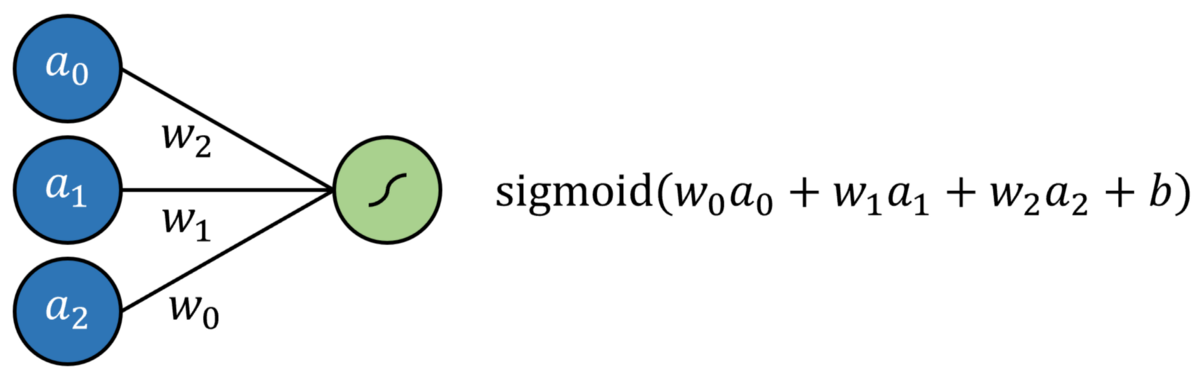

首先讓我們定義一個神經網絡:它是一個由輸入層,隱藏層和輸出層組成的體系結構,每一層的節點之間都有連接。 信息通過線性變換(權重和偏差)從非線性層(激活函數)從輸入層轉換為輸出層。 有一些方法可以更新模型的可訓練參數,例如…

Logistic回歸簡單定義為標準回歸,每個輸入均具有乘法系數,并添加了附加截距,所有截距均通過S型函數傳遞。 這可以通過沒有隱藏層的神經網絡來建模。 結果是通過S形輸出神經元的多元回歸。

通過將輸出神經元激活函數替換為線性激活函數(可以簡單地映射輸出f(x)= x,換句話說,它什么都不做),可以對線性回歸進行建模。

支持向量機(SVM)算法嘗試通過所謂的"內核技巧"將數據投影到新空間中,從而優化數據的線性可分離性。 轉換完數據后,該算法將繪制最能沿類邊界將數據分開的超平面。 超平面被簡單地定義為現有維度的線性組合,非常像2維的直線和3維的平面。從這個意義上講,人們可以將SVM算法看作是數據到新空間的投影,然后是 多重回歸。 神經網絡的輸出可以通過某種有界輸出函數傳遞,以實現概率結果。

當然,可能需要實施一些限制,例如限制節點之間的連接并固定某些參數,這些更改當然不會脫離"神經網絡"標簽的完整性。 也許需要添加更多的層,以確保支持向量機的這種表現能夠達到與實際交易一樣的效果。

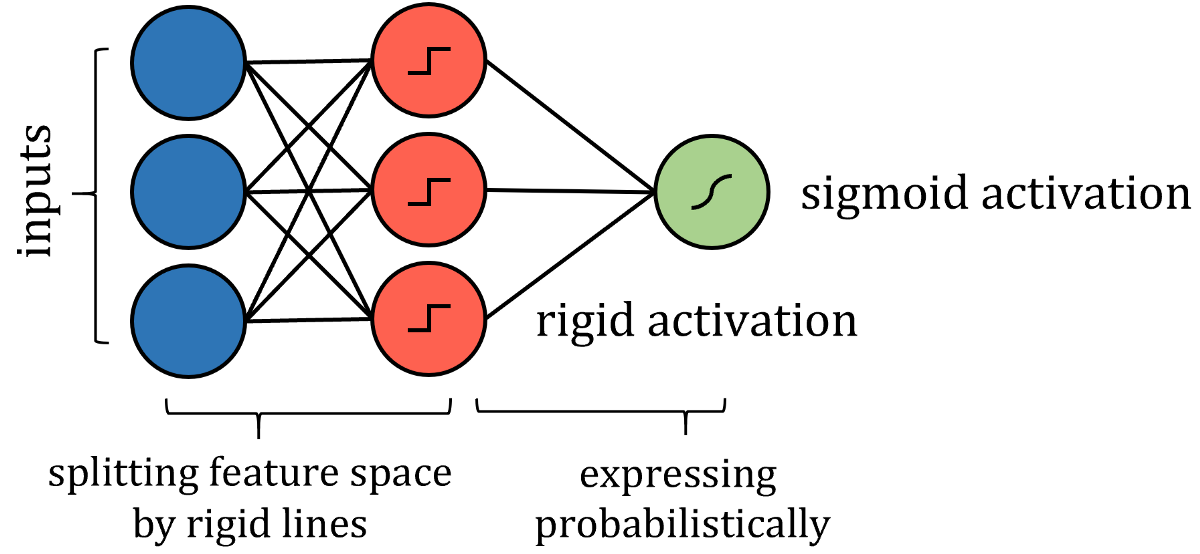

諸如決策樹算法之類的基于樹的算法有些棘手。 關于如何構建這種神經網絡的答案在于分析它如何劃分其特征空間。 當訓練點遍歷一系列拆分節點時,特征空間將拆分為多個超立方體。 在二維示例中,垂直線和水平線創建了正方形。

> Source: DataCamp community. Image free to share.

因此,可以通過更嚴格的激活來模擬沿特征線分割特征空間的類似方式,例如階躍函數,其中輸入是一個值或另一個值-本質上是分隔線。 權重和偏差可能需要實施值限制,因此僅用于通過拉伸,收縮和定位來定向分隔線。 為了獲得概率結果,可以通過激活函數傳遞結果。

盡管算法的神經網絡表示與實際算法之間存在許多技術差異,但重點是網絡表達的思想相同,并且可以以與實際算法相同的策略和性能來解決問題。

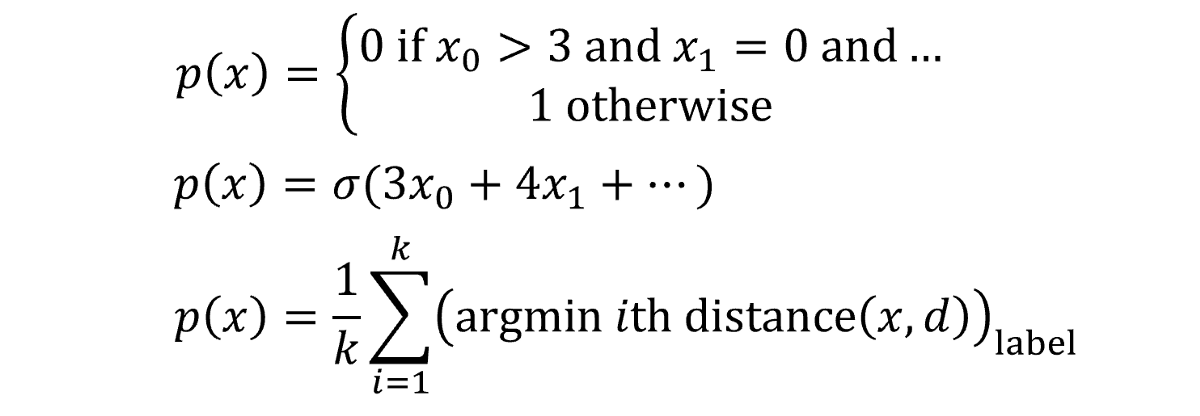

但是,也許您不滿意將算法粗略地轉換為神經網絡形式,或者希望看到通用的應用程序甚至更棘手的算法,例如k近鄰算法或樸素貝葉斯算法,而不是逐案解決。 答案就在于普遍近似定理-神經網絡大獲成功的數學解釋-本質上說,足夠大的神經網絡可以以任意精度對任何函數建模。 假設有一些函數f(x)代表數據; 對于每個數據點(x,y),f(x)始終返回等于或非常接近y的值。

建模的目的是找到該代表性或真理函數f(x),我們將其表示為預測的p(x)。 所有機器學習算法對這個任務的處理方式都大不相同,將不同的假設視為有效,并給出其最佳結果p(x)。 如果要寫出算法創建p(x)的方式,您可能會從條件列表到純粹的數學運算中得到任何東西。 描述函數如何將目標映射到輸入的函數實際上可以采用任何形式。

有時,這些功能起作用。 在其他時候,它們卻沒有—它們具有固定數量的參數,使用或保留它是一件重要的事情。 但是,神經網絡在尋找f(x)的方式上有些不同。

任何函數都可以由許多類似階梯的部分合理地逼近-步數越多,逼近的精度就越高。

這些步驟中的每一個都在神經網絡中表示,即隱層中具有S型激活函數的節點,該函數本質上是概率階躍函數。 本質上,每個節點都"分配"給函數f(x)的一部分。 然后,通過權重和偏差系統,網絡可以確定節點的存在,如果需要為特定輸入激活神經元,則將S型函數的輸入向無窮大(輸出為1),否則向負無窮大。 。 不僅在數值數據中而且在圖像中也觀察到了這種委托節點以尋找數據功能的特定部分的模式。

盡管通用逼近定理已擴展為適用于其他激活函數(如ReLU和神經網絡類型),但原理仍然適用:神經網絡的創建是完美的。 神經網絡不再依賴于復雜的方程和關系數學系統,而是將自身的一部分委派給數據功能的一部分,并通過蠻力記憶將其歸納在其指定區域內。 當這些節點被聚集到一個龐大的神經網絡中時,當它們實際上是巧妙設計的近似器時,結果是一個看似智能的模型。

假設神經網絡至少可以在理論上構造出一個函數,該函數基本上具有所需的精度(節點數越多,近似值越準確,當然不考慮過擬合的技術性),具有正確結構的神經網絡可以 對任何其他算法的預測函數p(x)建模。 關于其他任何機器學習算法,都不能這么說。

神經網絡使用的方法不是優化現有模型中的一些參數,例如多項式曲線或節點系統。 神經網絡是對數據建模的某種觀點,其目的不是要充分利用任何獨立系統,而是要直接逼近數據功能。 我們非常熟悉的神經網絡架構僅僅是一個真正想法的模型體現。

借助神經網絡的力量以及對深度學習的無底領域的不斷研究,無論是視頻,聲音,流行病學數據還是兩者之間的任何數據,都將能夠以前所未有的程度建模。 神經網絡確實是算法的算法。

除非另有說明,否則所有圖片均由作者創建。

(本文翻譯自Matthew P. Burruss的文章《Every machine Learning Algorithm Can Be Represented as a Neural Network》,參考:https://towardsdatascience.com/every-machine-learning-algorithm-can-be-represented-as-a-neural-network-82dcdfb627e3)