機器之心編輯部

訓練一個媲美 MJ 的文生圖模型,26K 美元就能實現(xiàn)了。

當前,最先進的文本到圖像(T2I)模型需要大量的訓練成本(例如,數(shù)百萬個 GPU 小時),這嚴重阻礙了 AIGC 社區(qū)的基礎創(chuàng)新,同時增加了二氧化碳排放。

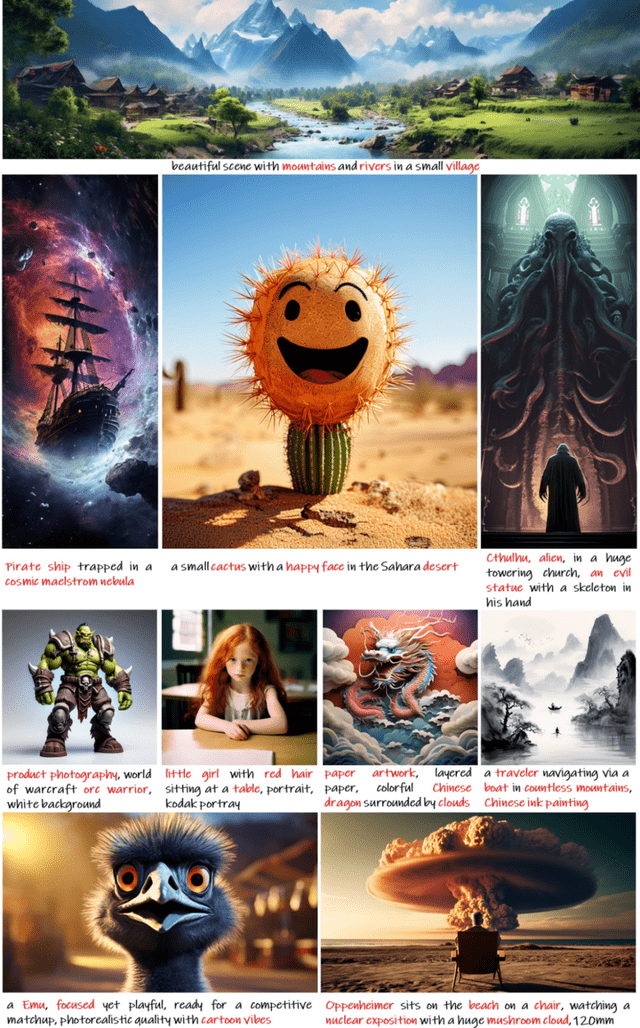

現(xiàn)在,來自華為諾亞方舟實驗室等研究機構的研究者聯(lián)合提出了開創(chuàng)性的文本到圖像(T2I)模型 PixArt-α, 只需要 Stable Diffusion v1.5 訓練時間的 10.8%(約 675 vs 約 6250 A100 GPU 天),省下近 30 萬美元(26000 美元 vs 320000 美元)。與更大的 SOTA 模型 RAPHAEL 相比,PixArt-α 的訓練成本僅為 1%,且支持直接生成高達 1024×1024 分辨率的高分辨率圖像。

PixArt-α 模型不僅大幅降低了訓練成本,還顯著減少了二氧化碳排放,同時提供了接近商業(yè)應用標準的高質(zhì)量圖像生成。PixArt-α 的出現(xiàn),為 AIGC 社區(qū)和初創(chuàng)公司提供了新的視角,以加速他們構建自己的高質(zhì)量且低成本的生成模型。

論文地址:

https://arxiv.org/abs/2310.00426

主頁:

https://pixart-alpha.Github.io/

項目地址:

https://github.com/PixArt-alpha/PixArt-alpha

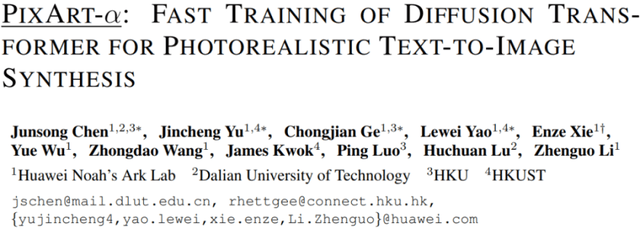

總的來說,PixArt-α 是一種基于 Transformer 的 T2I 擴散模型,其圖像生成質(zhì)量可以與最先進的圖像生成器(例如,Imagen [1],SDXL [2],甚至 Midjourney [3])相媲美,達到接近商業(yè)應用的標準。此外,它支持高達 1024×1024 分辨率的高分辨率圖像的直接生成,訓練成本低,如下圖 1 所示。

圖表 1.PixArt-α 產(chǎn)生的樣本展示出了其卓越的質(zhì)量,其特點是高精確度和準確性的圖像生成。

為了實現(xiàn)這個目標,該研究提出了三個核心設計:

訓練策略分解:該研究設計了三個獨特的訓練步驟,分別優(yōu)化像素間依賴關系,文本圖像對齊和圖像美學質(zhì)量;

高效的 T2I Transformer 結構:該研究將跨注意力模塊整合到 Diffusion Transformer(DiT)[6] 中,以注入文本信息并簡化計算復雜的類條件分支;

高信息密度數(shù)據(jù):該研究強調(diào)文本圖像對中概念密度的重要性,并利用大視覺語言模型自動標記密集的偽文本標簽以協(xié)助文本圖像對齊學習。

大量的實驗表明,PixArt-α 在圖像質(zhì)量、藝術性和語義控制方面表現(xiàn)出色。研究團隊希望 PixArt-α 能為 AIGC 社區(qū)和初創(chuàng)公司提供新的思路,以加速他們從頭開始構建自己的高質(zhì)量且低成本的生成模型。

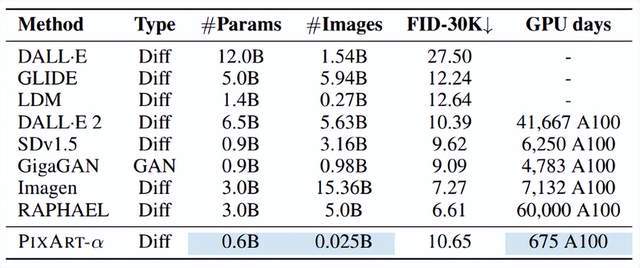

圖表 2.T2I 方法之間的二氧化碳排放和訓練成本比較。PixArt-α 實現(xiàn)了極低的訓練成本,僅為 26,000 美元。相比于 RAPHAEL,PixArt-α 的二氧化碳排放和訓練成本分別僅為 1.1% 和 0.85%。

從現(xiàn)象看本質(zhì):從訓練流程和數(shù)據(jù)的角度重新審視文生圖任務

從現(xiàn)有訓練流程出發(fā):文本到圖像(T2I)生成任務可以分解為三個方面:建模像素間關系、文本與圖像的精確對齊以及高審美質(zhì)量生成。然而,現(xiàn)有方法將這三個問題混合在一起,并直接使用大量數(shù)據(jù)從零開始訓練,導致訓練效率低下。

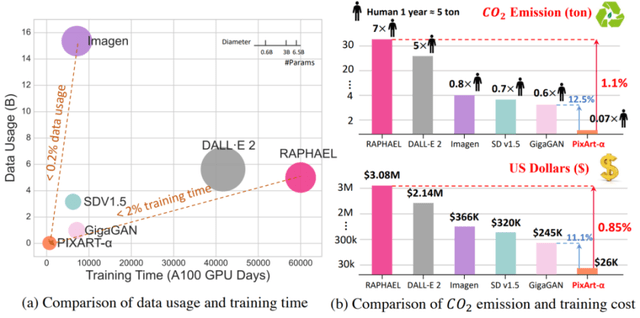

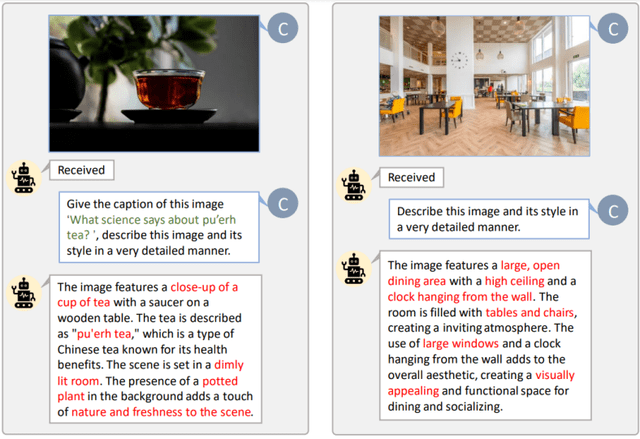

從訓練數(shù)據(jù)出發(fā):如圖 3 所示,現(xiàn)有的文本 - 圖像對常常存在文本 - 圖像不對齊、描述不足、包含大量不常見詞匯以及包含低質(zhì)量數(shù)據(jù)等問題。這些問題給訓練帶來了困難,導致需要進行數(shù)百萬次迭代才能實現(xiàn)文本和圖像之間的穩(wěn)定對齊。為了解決這個挑戰(zhàn),該研究引入了一個創(chuàng)新的自動標注流程來生成精確的圖像標題。

圖表 3.LAION [6] 原生標題 v.s. LLaVA 精細標題的對比。LLaVA 提供了信息密度更高的文本,幫助模型在每次迭代中掌握更多概念,提高了文本 - 圖像對齊的效率。

解耦訓練策略:不同數(shù)據(jù)獲取、強化不同能力

1. 像素間依賴學習

當前 class-condition 的方法 [7] 在生成語義連貫且像素邏輯合理的圖像上展現(xiàn)出了卓越的性能。訓練一個符合自然圖像分布的 class-condition 圖像生成模型,不僅訓練相對簡單,成本也較低。該研究還發(fā)現(xiàn),適當?shù)某跏蓟梢詷O大地提升圖像生成模型的訓練效率。因此,PixArt 模型采用了一個 Imag.NET 預訓練模型作為基礎,來增強模型的性能。此外,該研究也提出了重參數(shù)化來兼容預訓練權重,以確保最佳的算法效果。

2. 文本圖像對齊

從預訓練的 class-condition 圖像生成模型過渡到基于文本的圖像生成模型的主要挑戰(zhàn)在于如何實現(xiàn)文本概念與圖像之間的精確對齊。這個對齊過程既耗時,也具有挑戰(zhàn)性。為了有效地促進這個過程,該研究構建了一個高概念密度的由精確的文本 - 圖像對組成的數(shù)據(jù)集。通過使用精確且信息豐富的數(shù)據(jù),幫助模型在單次訓練迭代中有效學習更多的概念,同時相較于之前的數(shù)據(jù)集,遇到的模糊性大大減少。這種策略性的方法賦予了 PixArt-α 高效地將文本描述與圖像對齊的能力。

3. 圖像美學質(zhì)量

在第三階段,該研究對模型進行了微調(diào),利用了高質(zhì)量的美學數(shù)據(jù)并提高了模型的分辨率,使得模型具有生成高質(zhì)量圖像的能力。值得注意的是,研究團隊觀察到模型在該階段的收斂速度顯著加快,這主要歸功于前兩階段學習到的的強大的先驗知識。

刪繁就簡:高效 T2I Transformer 架構

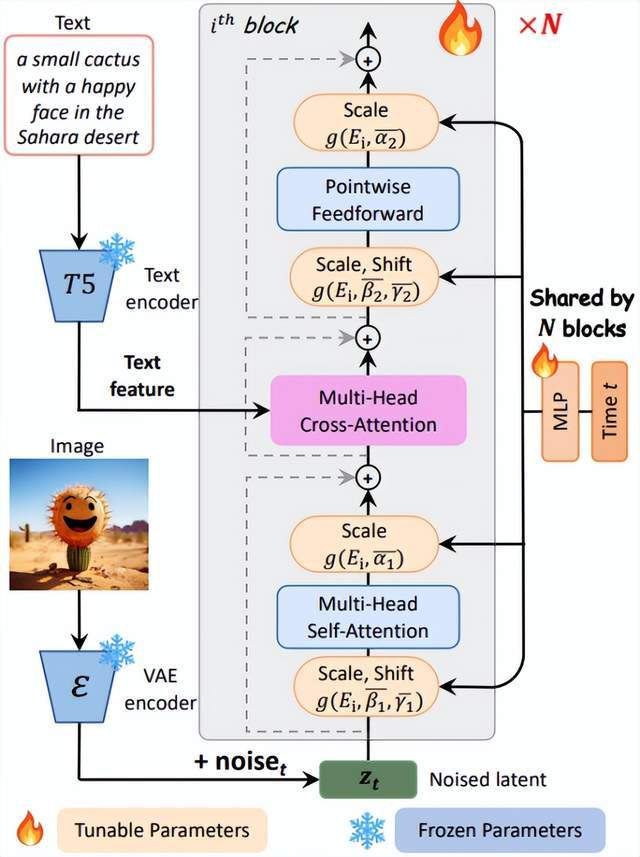

PixArt-α 采用了 Diffusion Transformer (DiT) 作為基礎架構,如圖 4 所示,并創(chuàng)新地提出了以下幾個專門的設計方案來處理 T2I 任務:

圖表 4.PixArt-α 模型架構。

Cross-Attention layer 該研究在 DiT 模塊中加入了一個多頭交叉注意力層。它位于自注意力層和前饋層之間,使得模型能夠靈活地與從語言模型中提取的文本特征進行交互。為了利用預訓練權重,該研究將交叉注意力層的輸出投影層權重初始化為零,有效地作為恒等映射來保留輸入供后續(xù)層使用。

AdaLN-single 該研究發(fā)現(xiàn)在 DiT 的自適應標準化層(adaLN)中,線性投影(MLP)占據(jù)了大量(27%)的參數(shù)。研究團隊提出了 adaLN-single 模塊來降低模型的參數(shù)量,它只在噪聲進入模型第一層之前,僅使用時間特征嵌入作為輸入進行獨立控制(如圖 4 右側(cè)所示), 并在所有層中共享。研究團隊為每一層設置了層特定的可學習特征嵌入,它可適應性地調(diào)整不同層中的尺度和位移參數(shù)。

重參數(shù)化 該研究提出了重參數(shù)化技巧來保持與預訓練權重的兼容性。

實驗表明,通過整合全局 MLP 和層次嵌入來處理時間步信息,以及采用跨注意力層處理文本信息,可以在有效減小模型大小的同時,保持模型的生成能力。

數(shù)據(jù)構建:全新自動化圖文對標注工具

該研究發(fā)現(xiàn) LAION 數(shù)據(jù)集中存在大量簡單的商品樣圖,并選擇使用專為多樣性目標分割設計的 SAM 數(shù)據(jù)集 [8],其圖像中包含了豐富多樣的對象,即較高的信息 / 概念密度,更加貼合前文高信息密度數(shù)據(jù)可以幫助圖文對齊的論述。標注流程如圖 5 所示。

圖表 5.為 LAION(左圖)和 SAM(右圖)進行自定義提示的自動標注功能。圖中綠色高亮的詞匯代表 LAION 中的原始標題,而紅色標注的則是 LLaVA 標注的詳細信息。

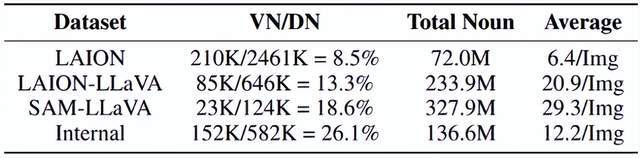

研究團隊對 LAION 和 SAM 兩個數(shù)據(jù)集進行了名詞統(tǒng)計,如圖 6 所示。LAION 的名詞統(tǒng)計顯示,雖然其總的名詞種類多達 2451K 種,但有效名詞的比例僅為 8%,這意味著其中 91% 以上的名詞是不常見的,這可能會導致模型訓練的不穩(wěn)定。相比之下,LAION-LLaVA 的統(tǒng)計結果顯示,有效名詞的比例有所提升,總名詞數(shù)量和每張圖像的平均名詞數(shù)量顯著增加。這表明,LLaVA 生成的標簽能夠盡量涵蓋每張圖片中更多的物體和概念。同樣的,在實際使用的 SAM 數(shù)據(jù)以及內(nèi)部數(shù)據(jù)中,各項指標都有較 LAION-LLaVA 有更大的提升,這體現(xiàn)了更高的概念密度數(shù)據(jù)在訓練中的重要性。

圖表 6.不同數(shù)據(jù)集的名詞概念統(tǒng)計。VN:有效的不同名詞種類(出現(xiàn)次數(shù)超過10次);DN:總的不同名詞種類;Average:每張圖片的平均名詞數(shù)量。

量化指標驗證:指標下的能力

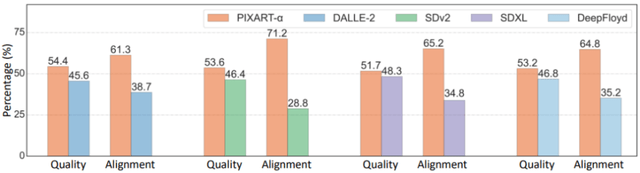

該研究最終在 User study、T2ICompBench [9] 以及 MSCOCO Zero-shot FID 三項指標上驗證了 PixArt-α 的能力。更多評價結果與討論請參考原論文。

圖表 7.根據(jù)對 Ernie-vilg 2.0 [10] 的 300 個固定提示的用戶體驗研究,比例值表示了偏好對應模型的用戶百分比。PixArt-α 在質(zhì)量和對齊度方面都表現(xiàn)出超越其他模型的優(yōu)秀性能。

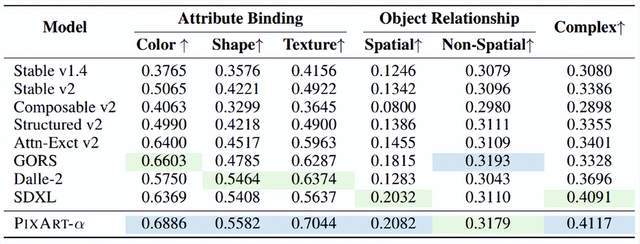

如下圖表 8 所示,在 T2I-CompBench 上進行的對齊評估中,PixArt-α 在屬性綁定、對象關系和復雜組合方面展示出卓越的性能,這表明 PixArt-α 具有優(yōu)越的組合生成能力。其中,用藍色高亮表示最好的值,用綠色表示次優(yōu)的值。基線數(shù)據(jù)來源于 T2ICompBench。

圖表 8

該研究全面比較了 PixArt-α 和最近的 T2I 模型,考慮了幾個關鍵因素:模型大小、訓練圖像總量、COCO FID-30K 分數(shù)(Zero-shot)以及計算成本(GPU 天數(shù)),結果如下圖表 9 所示。該研究提出的高效方法 PixArt-α 顯著減少了資源消耗,包括訓練數(shù)據(jù)使用和訓練時間。基線數(shù)據(jù)來源于 GigaGAN [11]。

圖表 9

可視化驗證:No cheery-pick battle

用于可視化的圖像文本均取自其他方法中,本文中的圖片全部隨機生成,無需 cheery-pick。

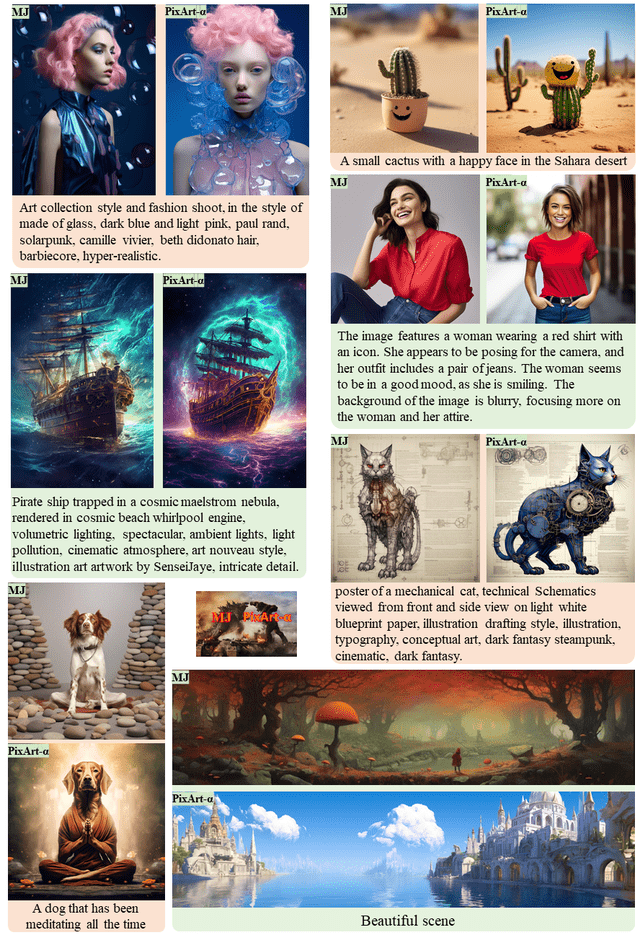

1. 與 Midjourney 對比

圖表 10 與 Midjourney 的比較:此次比較使用的提示是從網(wǎng)上隨機抽樣的。為了確保公平的比較,研究團隊選擇了兩種模型生成的第一個結果進行對比。

圖表 10

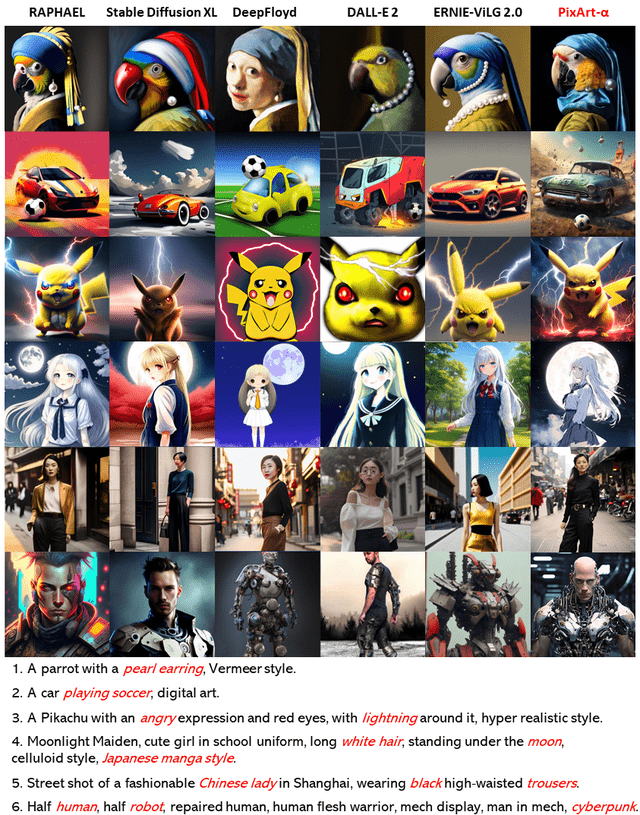

2. 與更多文生圖方法的對比

圖表 11 PixArt-α 與近期代表性的方法對比,如 Stable Diffusion XL [2]、DeepFloyd [12]、DALL-E 2 [13]、ERNIE-ViLG 2.0 [10] 以及 RAPHAEL [5]。所有方法都使用了與 RAPHAEL 中相同的提示詞,其中人類藝術家希望在生成圖像中保留的詞語被用紅色高亮。各行的具體提示在圖示下方提供。

圖表 11

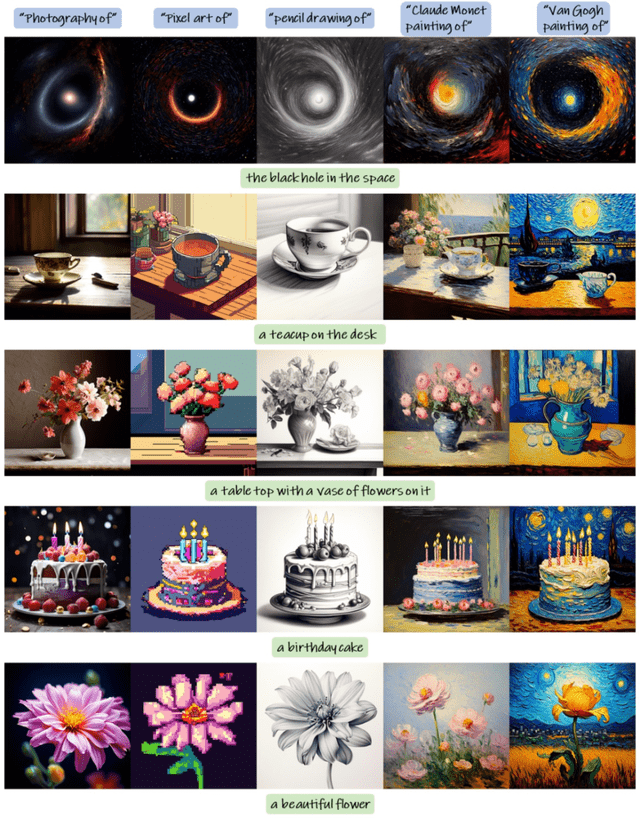

3. 文本直接控制風格

圖表 12 提示詞混合:PixArt-α 能夠直接通過文本提示操控圖像風格。利用風格控制物體,PixArt-α 生成了五個輸出樣本。例如,位于圖示左角的第一個例子的第二個圖片,使用的提示是 “Pixel Art of the black hole in the space”。

圖表 12

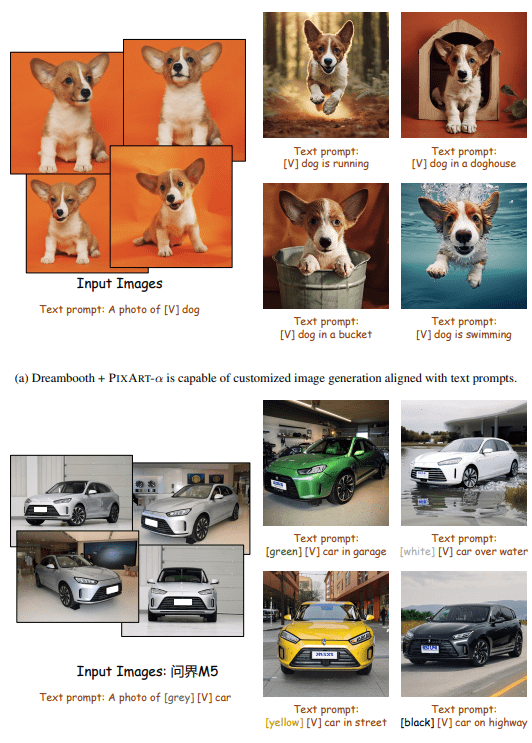

方法可拓展性:ControlNet & Dreambooth

如下圖表 13 所示,PixArt-α 能夠與 Dreambooth [14] 結合使用。只需給定幾張圖片和文本提示,PixArt-α 就能生成高保真度的圖像,這些圖像能展示與環(huán)境的自然互動(a)和精確的物體顏色修改(b)。這證明了 PixArt-α 能生成具有卓越質(zhì)量的圖像,并且在定制擴展方面具有強大的能力。

圖表 13

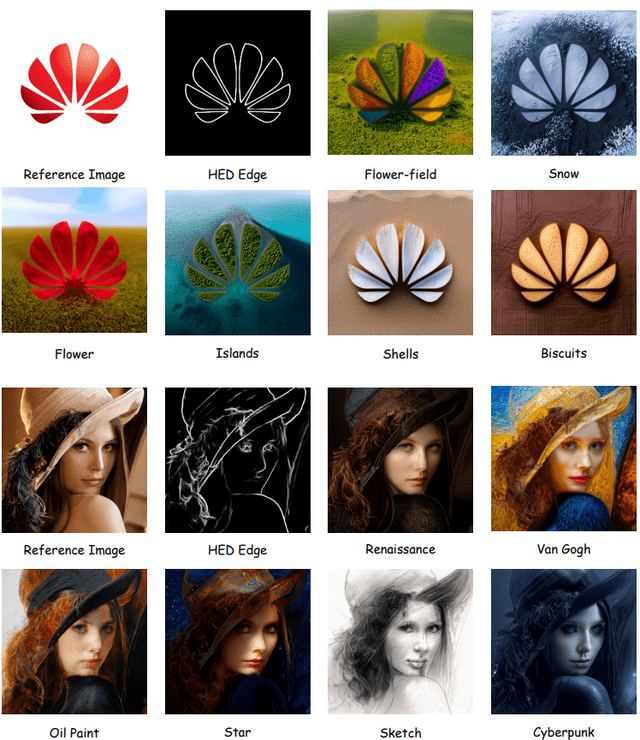

圖表 14:PixArt-α+ControlNet [15] 定制樣本。該研究使用輸入圖片生成相應的 HED 邊緣圖像,并將它們作為 PixArt-α ControlNet 的控制信號。

圖表 14

總結

總的來說,該研究提出了 PixArt-α,這是一種基于 Transformer 的文本到圖像(T2I)擴散模型,它在顯著降低訓練成本和二氧化碳排放的同時,實現(xiàn)了超強的圖像生成質(zhì)量。PixArt-α 的三大核心設計,包括訓練策略的分解、高效的 T2I Transformer 架構和高信息量的數(shù)據(jù),都為 PixArt-α 的成功做出了貢獻。通過大量的實驗,該研究證明了 PixArt-α 在圖像生成質(zhì)量上達到了接近商業(yè)應用的標準。有了以上的設計,PixArt-α 為 AIGC 社區(qū)和初創(chuàng)公司提供了新的視角,使他們能夠構建自己的高質(zhì)量且低成本的 T2I 模型。研究團隊希望這項工作能激發(fā)這個領域的進一步創(chuàng)新和進步。

[1] Chitwan Saharia, William Chan, Saurabh Saxena, Lala Li, Jay Whang, Emily L Denton, Kamyar Ghasemipour, Raphael Gontijo Lopes, Burcu Karagol Ayan, Tim Salimans, et al. Photorealistic text-to-image diffusion models with deep language understanding. In NeurIPS, 2022.

[2] Dustin Podell, Zion English, Kyle Lacey, Andreas Blattmann, Tim Dockhorn, Jonas Muller, Joe ¨ Penna, and Robin Rombach. Sdxl: Improving latent diffusion models for high-resolution image synthesis. In arXiv, 2023.

[3] Midjourney. Midjourney, 2023. URL https://www.midjourney.com.

[4] Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, and Bjorn Ommer. High-resolution image synthesis with latent diffusion models. In CVPR, 2022.

[5] Zeyue Xue, Guanglu Song, Qiushan Guo, Boxiao Liu, Zhuofan Zong, Yu Liu, and Ping Luo. Raphael: Text-to-image generation via large mixture of diffusion paths. In arXiv, 2023b.

[6] Christoph Schuhmann, Richard Vencu, Romain Beaumont, Robert Kaczmarczyk, Clayton Mullis, Aarush Katta, Theo Coombes, Jenia Jitsev, and Aran Komatsuzaki. Laion-400m: Open dataset of clip-filtered 400 million image-text pairs. In arXiv, 2021.

[7] William Peebles and Saining Xie. Scalable diffusion models with transformers. In ICCV, 2023.

[8] Alexander Kirillov, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao, Spencer Whitehead, Alexander C Berg, Wan-Yen Lo, et al. Segment anything. In ICCV, 2023.

[9] Kaiyi Huang, Kaiyue Sun, Enze Xie, Zhenguo Li, and Xihui Liu. T2i-compbench: A comprehensive benchmark for open-world compositional text-to-image generation. In ICCV, 2023.

[10] Zhida Feng, Zhenyu Zhang, Xintong Yu, Yewei Fang, Lanxin Li, Xuyi Chen, Yuxiang Lu, Jiaxiang Liu, Weichong Yin, Shikun Feng, et al. Ernie-vilg 2.0: Improving text-to-image diffusion model with knowledge-enhanced mixture-of-denoising-experts. In CVPR, 2023.

[11] Minguk Kang, Jun-Yan Zhu, Richard Zhang, Jaesik Park, Eli Shechtman, Sylvain Paris, and Taesung Park. Scaling up gans for text-to-image synthesis. In CVPR, 2023.

[12] DeepFloyd. Deepfloyd, 2023. URL https://www.deepfloyd.ai/

[13] OpenAI. Dalle-2, 2023. URLhttps://openai.com/dall-e-2.

[14] Nataniel Ruiz, Yuanzhen Li, Varun Jampani, Yael Pritch, Michael Rubinstein, and Kfir Aberman. Dreambooth: Fine tuning text-to-image diffusion models for subject-driven generation. In arXiv, 2022.

[15] Lvmin Zhang, Anyi Rao, and Maneesh Agrawala. Adding conditional control to text-to-image diffusion models. In ICCV, 2023.