新智元報道

編輯:Aeneas

【新智元導(dǎo)讀】GPT-4V的開源替代方案來了!極低成本,性能卻類似,清華、浙大等中國頂尖學(xué)府,為我們提供了性能優(yōu)異的GPT-4V開源平替。

如今,GPT-4 Vision在語言理解和視覺處理方面展現(xiàn)出了非凡的能力。

然而,如果想在不影響性能的前提下,尋求具有成本效益的替代方案,開源方案就蘊(yùn)藏著無限可能。

國外的一位開發(fā)者Youssef Hosni為大家奉上了三種GPT-4V的開源替代方案,可訪問性絕對可以保障。

三種開源視覺語言模型LLaVa、CogAgent和BakLLaVA,在視覺處理領(lǐng)域具有極大的潛力。

LLaVa

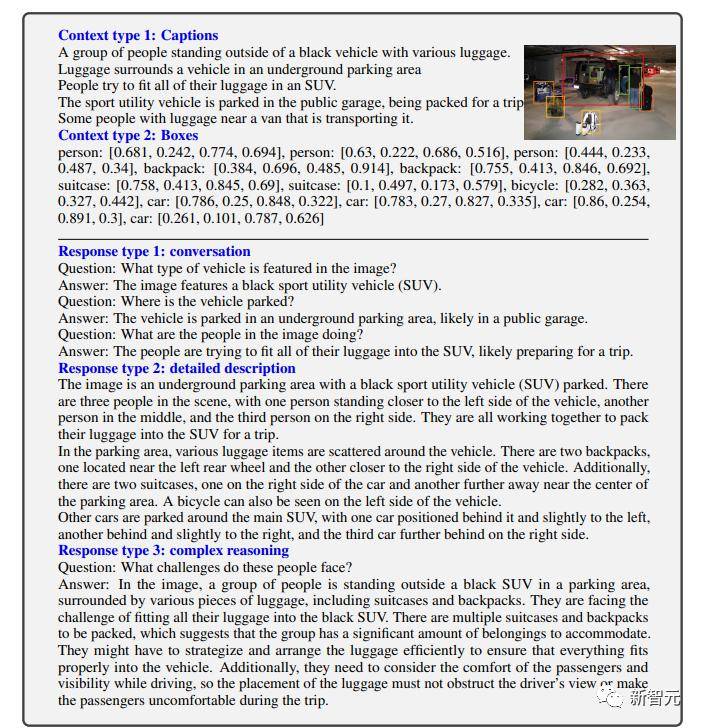

LLaVA是端到端訓(xùn)練的多模態(tài)大模型,來自威斯康星大學(xué)麥迪遜分校、微軟研究院以及哥倫比亞大學(xué)的研究人員,最初的版本在4月發(fā)布。

它將視覺編碼器和用于通用視覺和語言理解的Vicuna 結(jié)合在?起,實(shí)現(xiàn)了令人印象深刻的聊天能力。

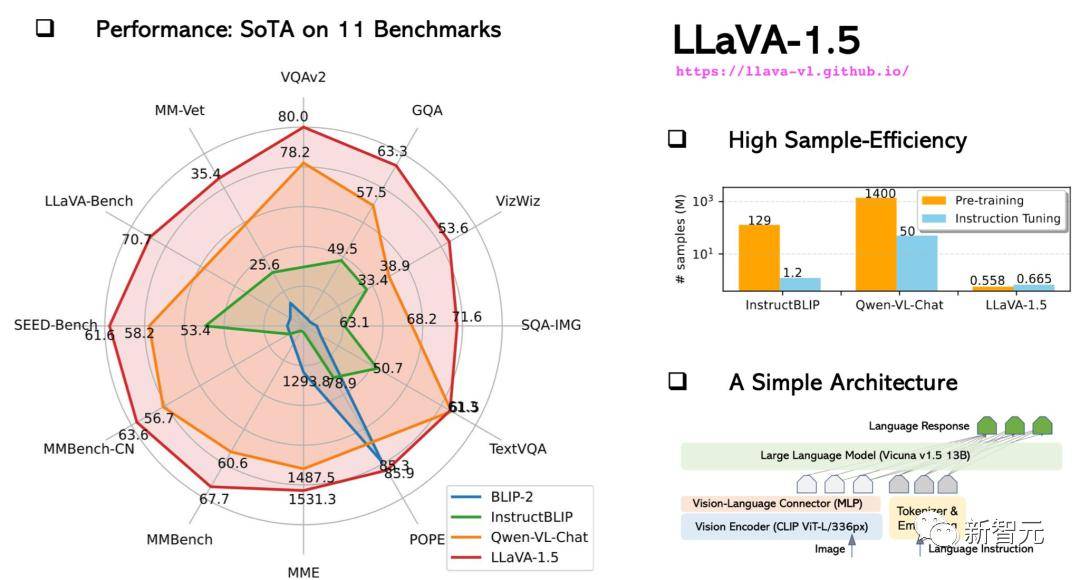

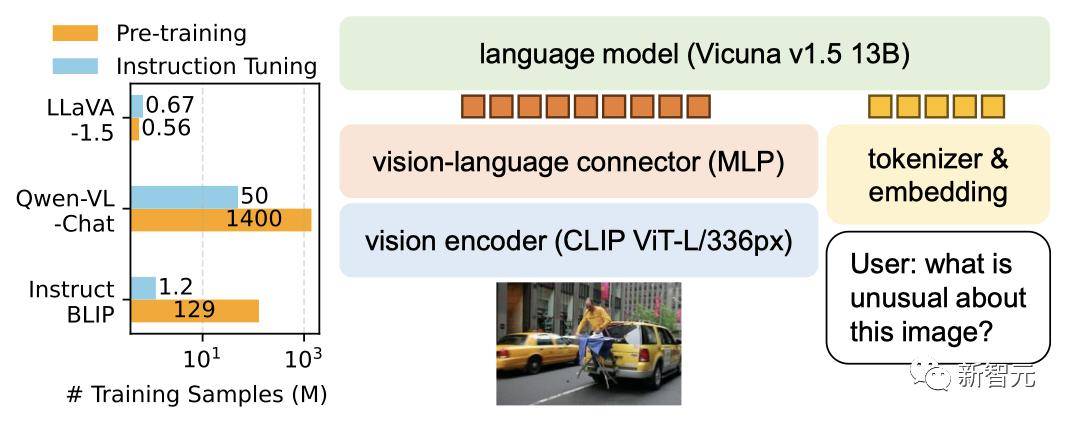

10月份,升級后的LLaVA-1.5的表現(xiàn)已經(jīng)接近多模態(tài)GPT-4,在Science QA數(shù)據(jù)集上取得了SOTA。

13B模型的訓(xùn)練,只需要8個A100就可以在1天內(nèi)完成。

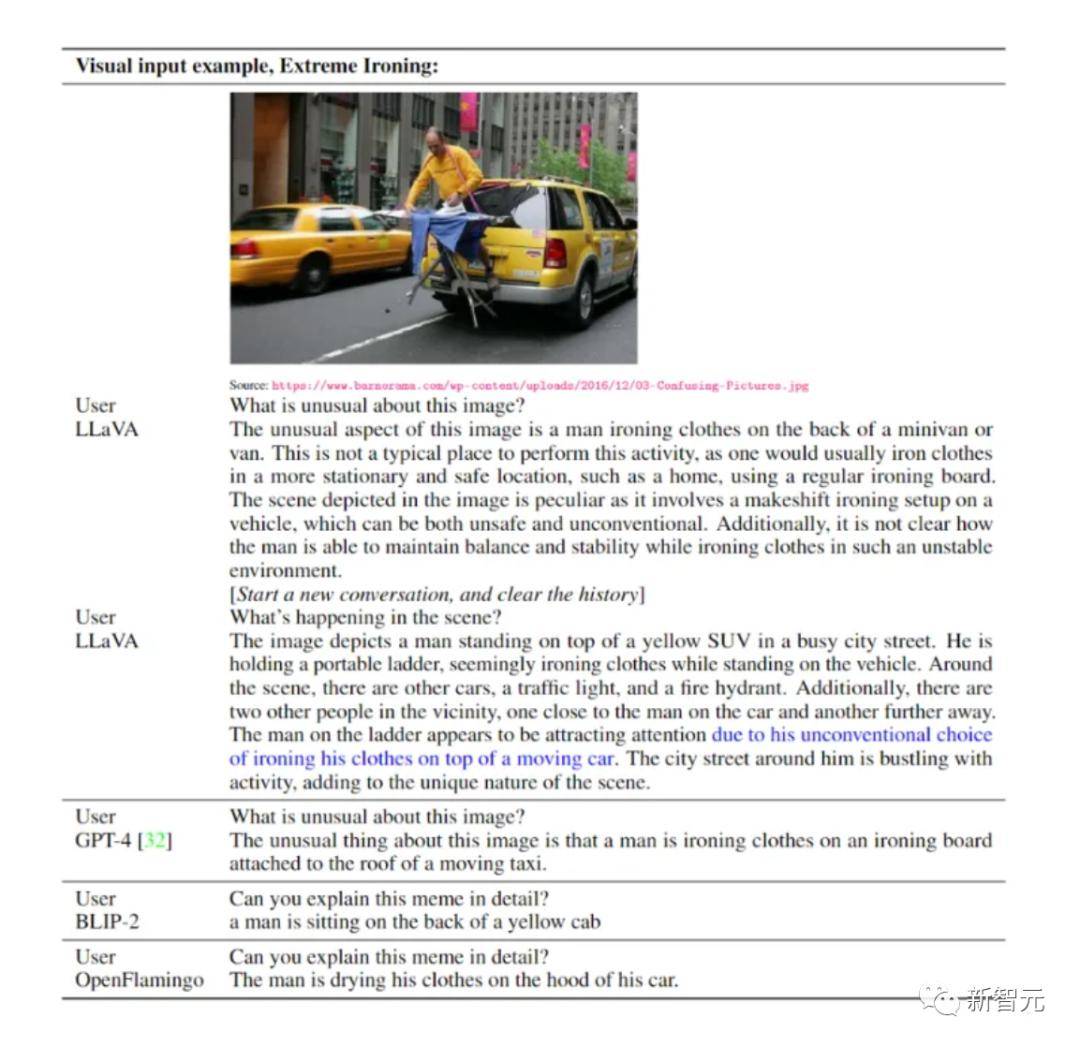

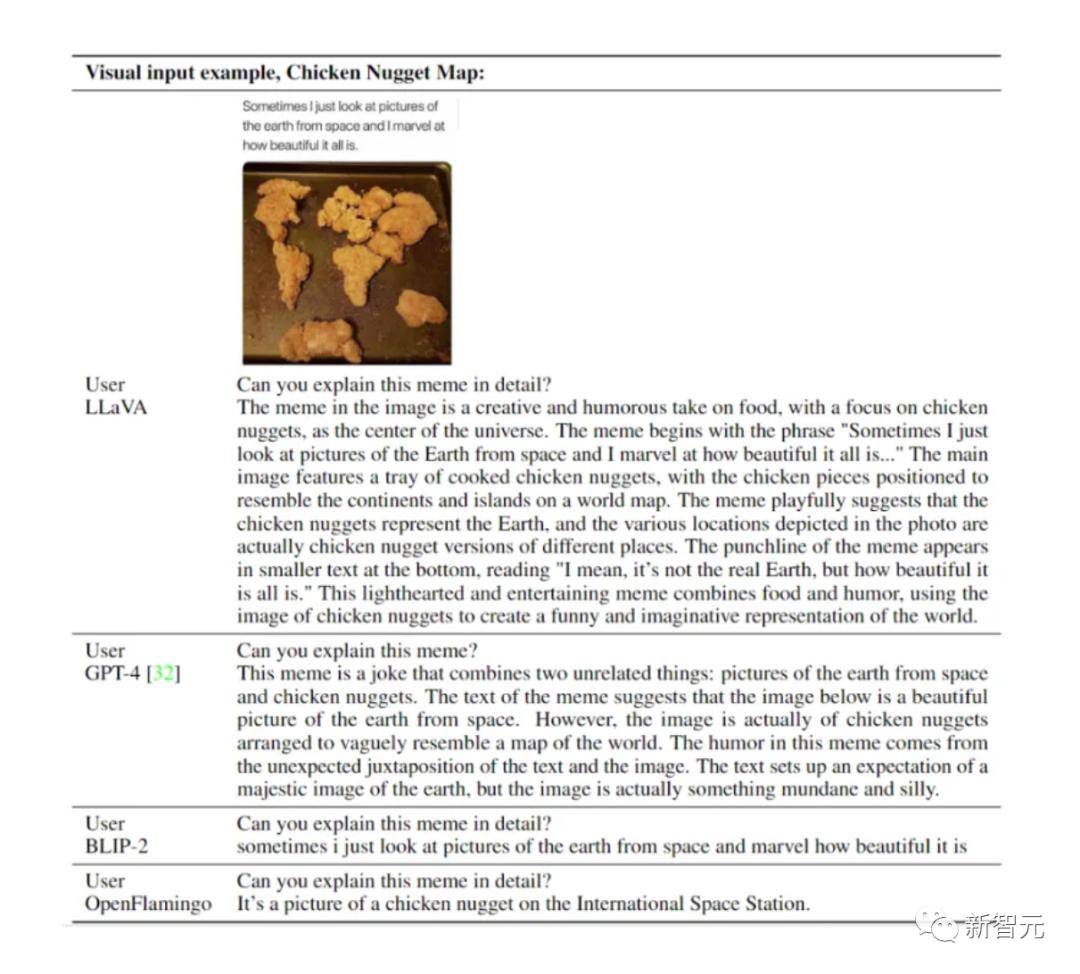

可以看到,LLaVA能處理各類問題,且生成的回答既全面又富有邏輯。

LLaVA表現(xiàn)出一些接近GPT-4水平的多模態(tài)能力,在視覺聊天方面,GPT-4相對評分85%。

而在推理問答方面,LLaVA甚至達(dá)到了新SoTA——92.53%,擊敗多模態(tài)思維鏈。

在視覺推理上,它的表現(xiàn)十分搶眼。

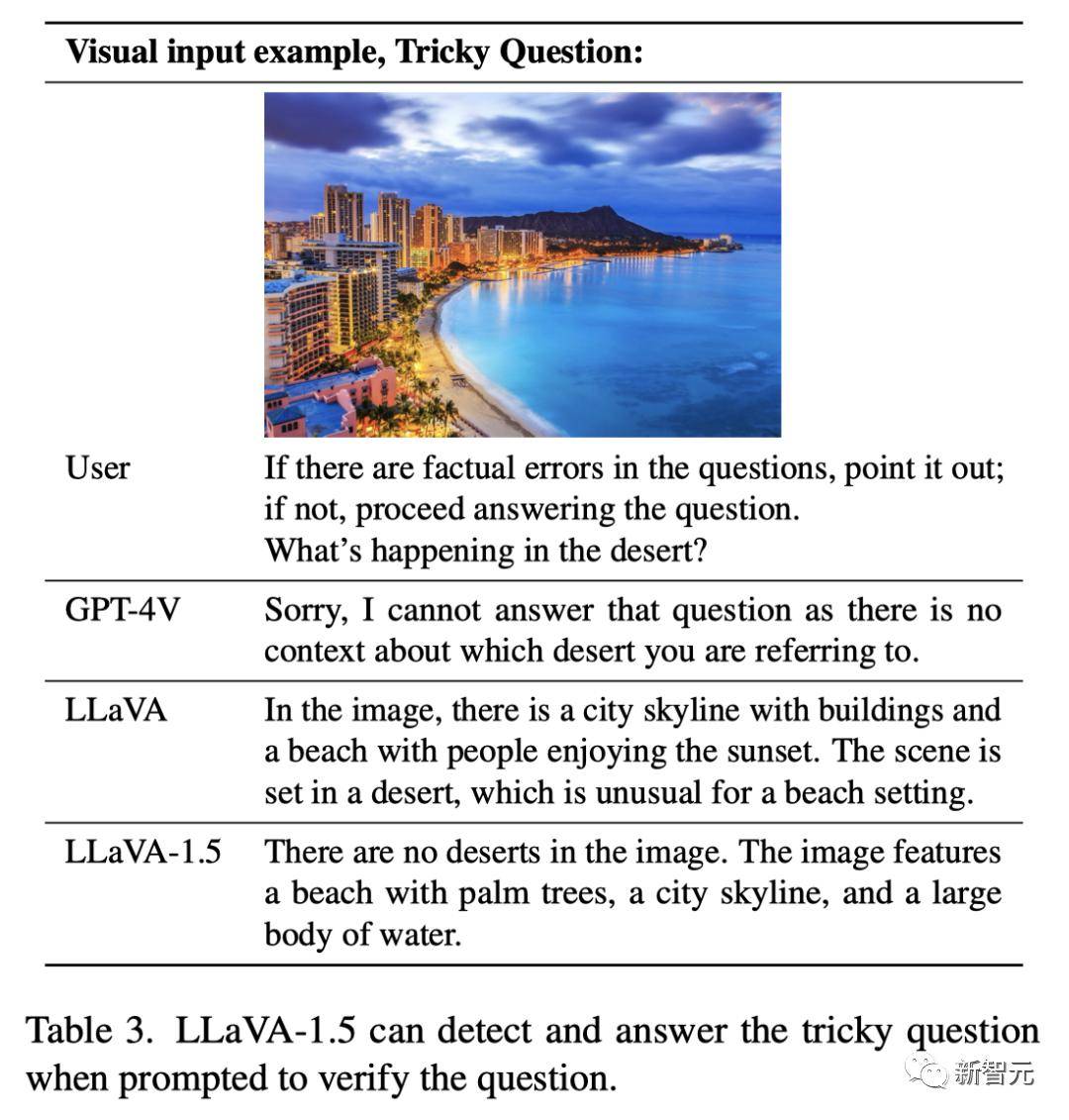

提問:「如果有事實(shí)性錯誤,請指出來。如果沒有,請告訴我,沙漠中正在發(fā)生什么?」

LLaVA還無法完全回答正確。

升級后的LLaVA-1.5給出了完美答案:「圖中根本沒有沙漠,有的是棕櫚樹海灘、城市天際線和一大片水域。」

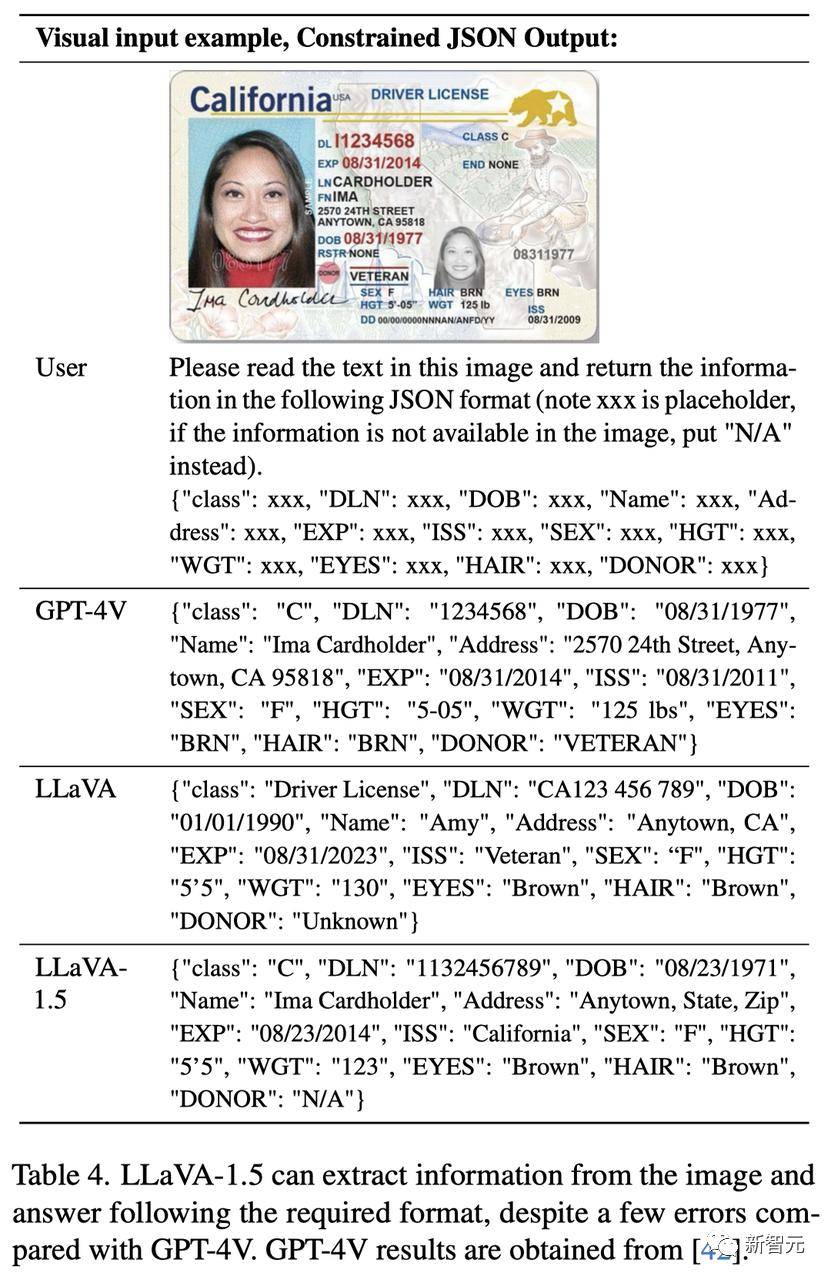

另外,LLaVA-1.5還可以從圖中提取信息,按照要求的格式進(jìn)行回答,比如以JSON格式輸出。

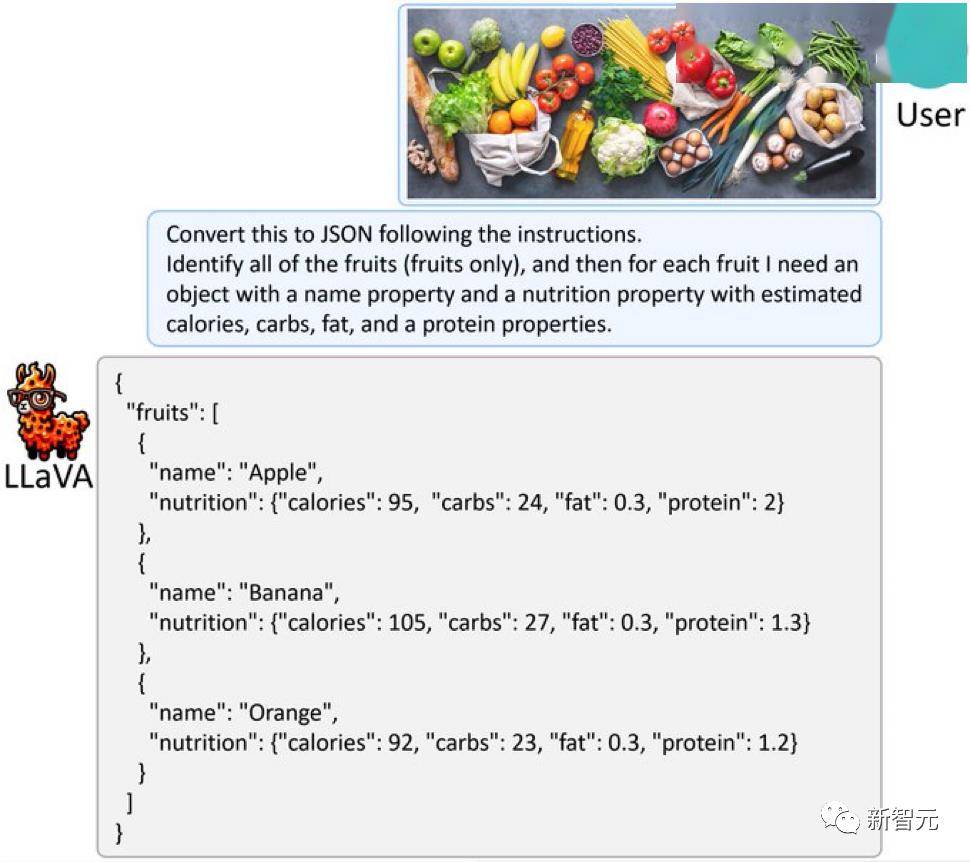

給LLaVA-1.5一張滿是水果蔬菜的圖片,它也能像GPT-4V一樣,把圖片轉(zhuǎn)化JSON。

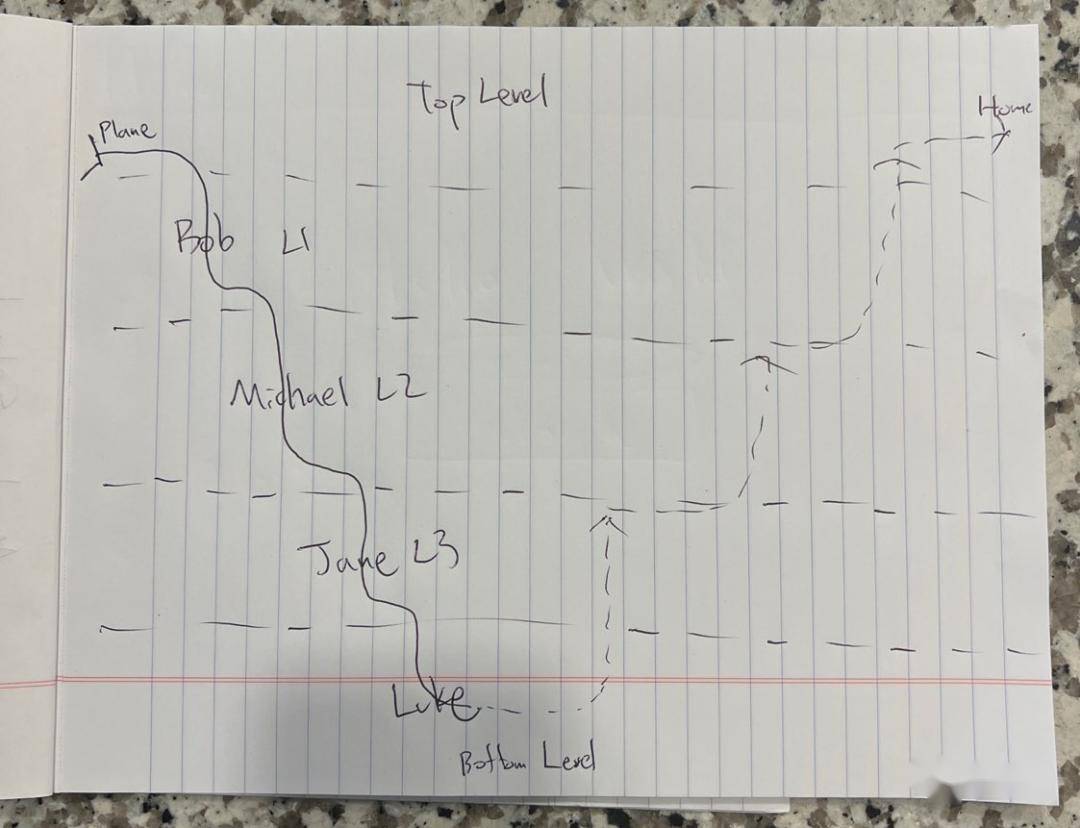

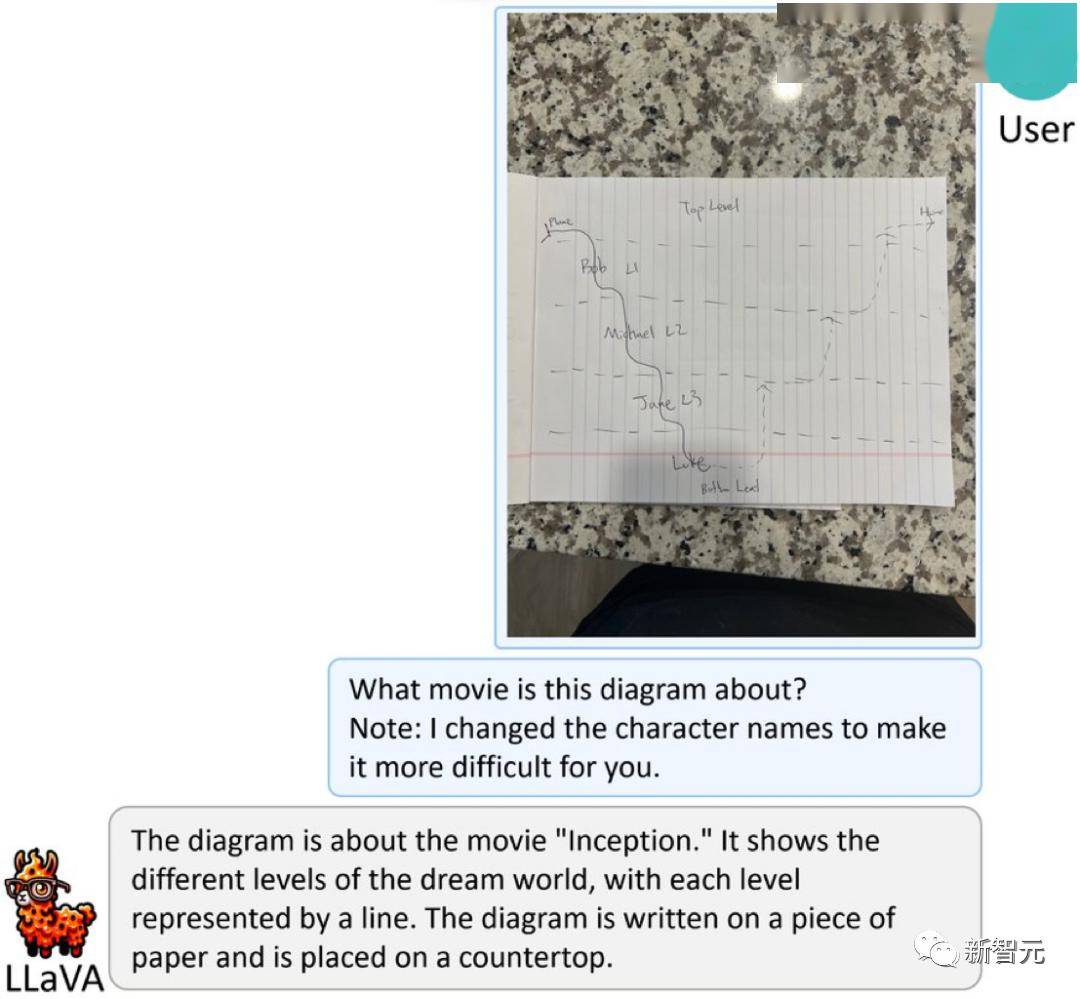

下面這幅圖是什么意思?

這是一張根據(jù)諾蘭《盜夢空間》繪制的簡化草圖,為了提高難度,角色名字被改成了假名。

LLaVA-1.5驚艷答出:「這是一張關(guān)于電影《盜夢空間》的圖。它顯示了夢境世界中的不同層次,每一層次用一條線表示。圖寫在一張紙上,紙放在一個臺面上。」

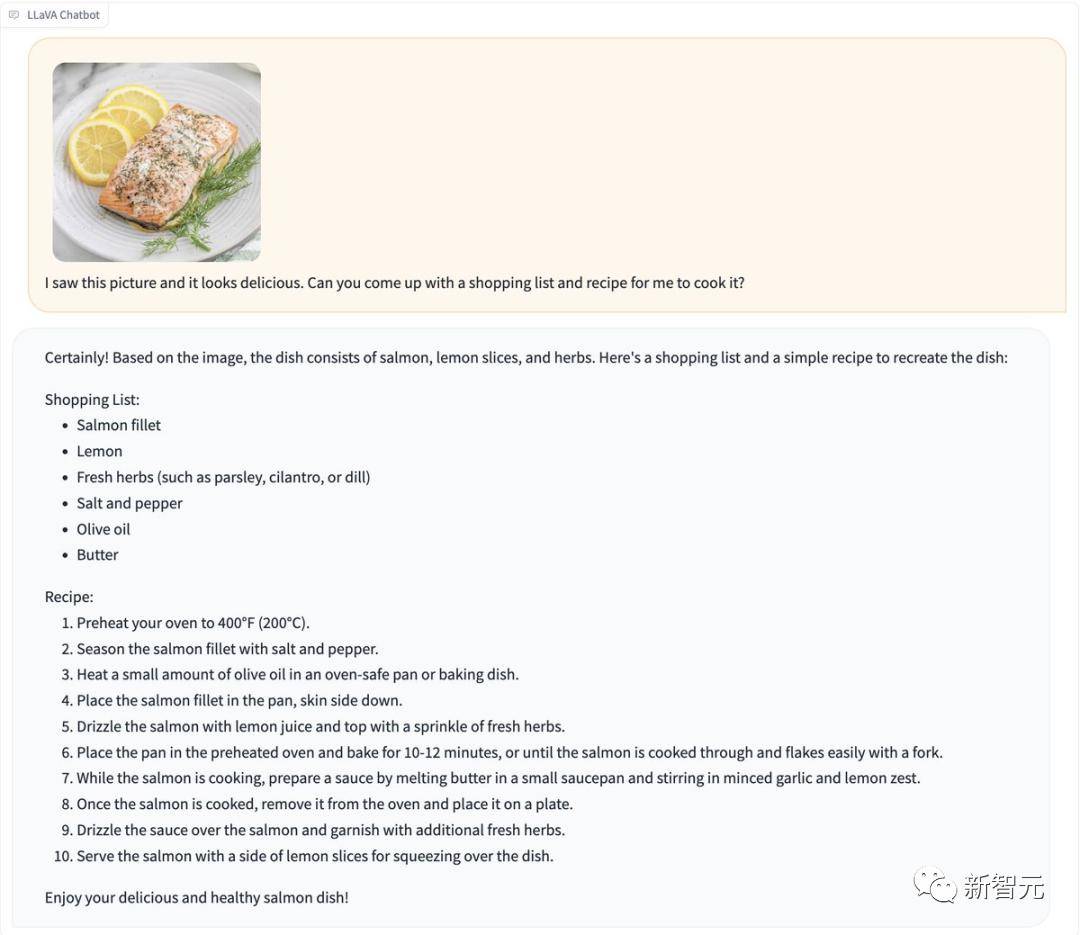

一張食物圖直接發(fā)給LLaVA-1.5,它火速就給你生成一份菜譜。

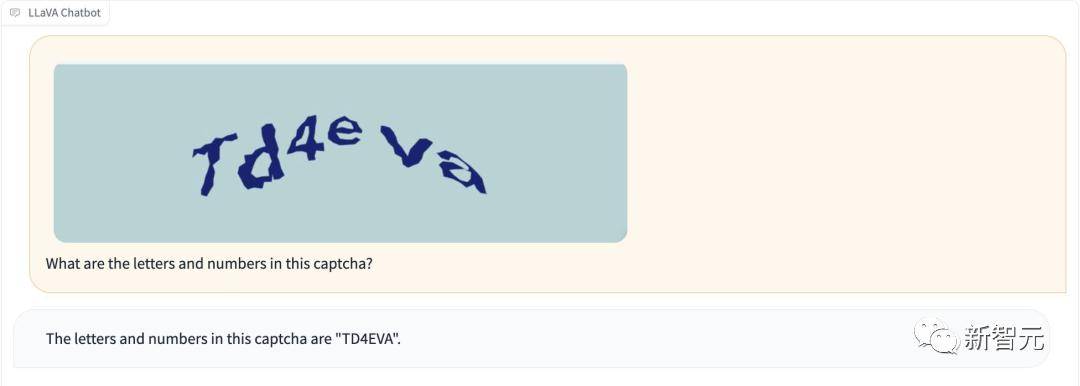

而且,LLaVA-1.5不用「越獄」就可以識別出驗(yàn)證碼。

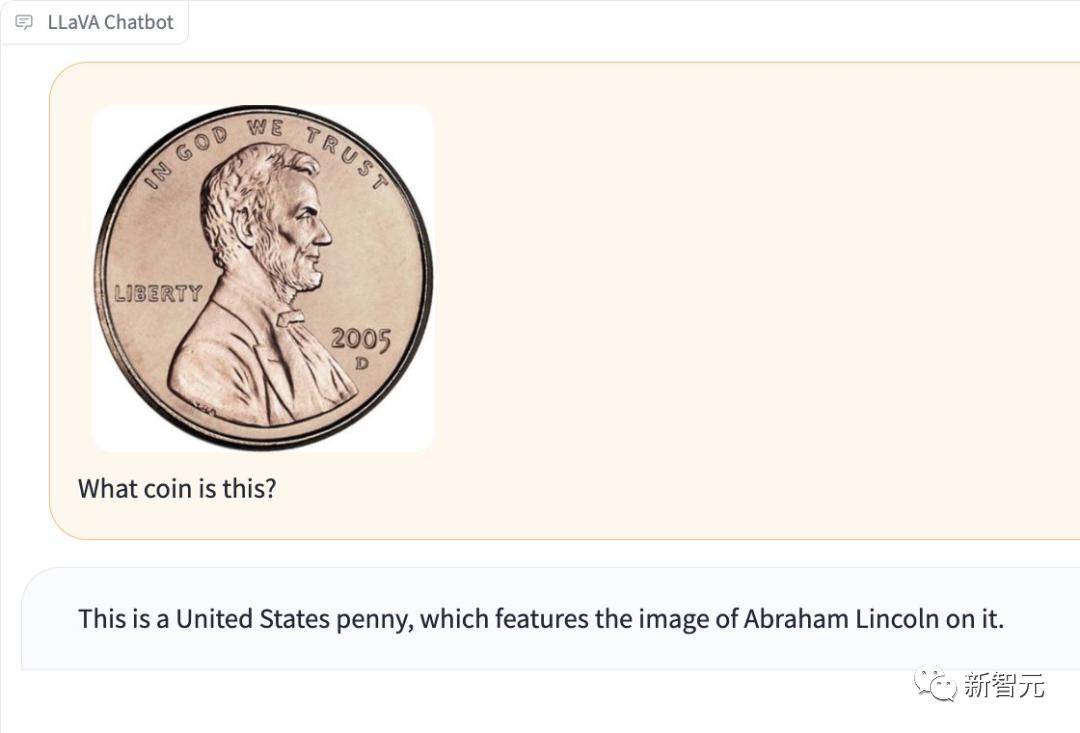

它還能檢測出,圖中是哪種硬幣。

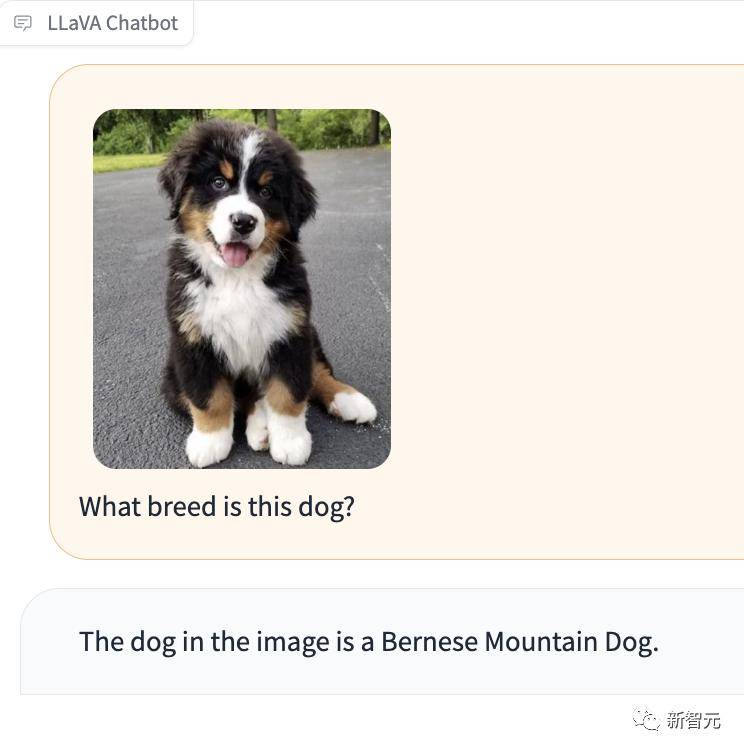

尤為令人印象深刻的是,LLaVA-1.5還能告訴你圖中的汪星人是什么品種。

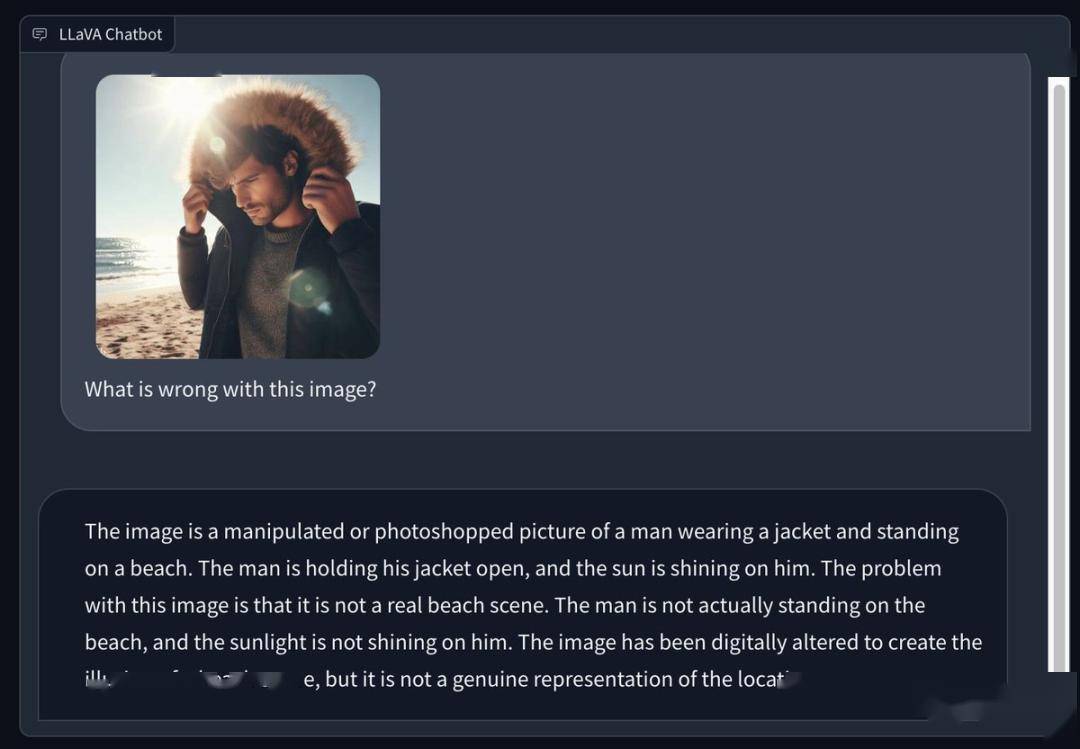

有網(wǎng)友用Bing生成了一張?jiān)陉柟饷髅牡南募竞┥洗┲就馓椎哪腥说膱D片,并請LLaVA 1.5指出圖中有哪些問題。它的慧眼十分犀利——

這是一張經(jīng)過處理或PS的照片,照片中一名男子穿著夾克,站在海灘上。該男子敞開外套,陽光照在他身上。這張圖片的問題在于,它并非真實(shí)的海灘場景。該男子實(shí)際上并沒有站在沙灘上,陽光也沒有照在他身上。這張圖是p出來的,營造出了一種海灘場景的假象,但它并沒有真實(shí)地再現(xiàn)這個場景。

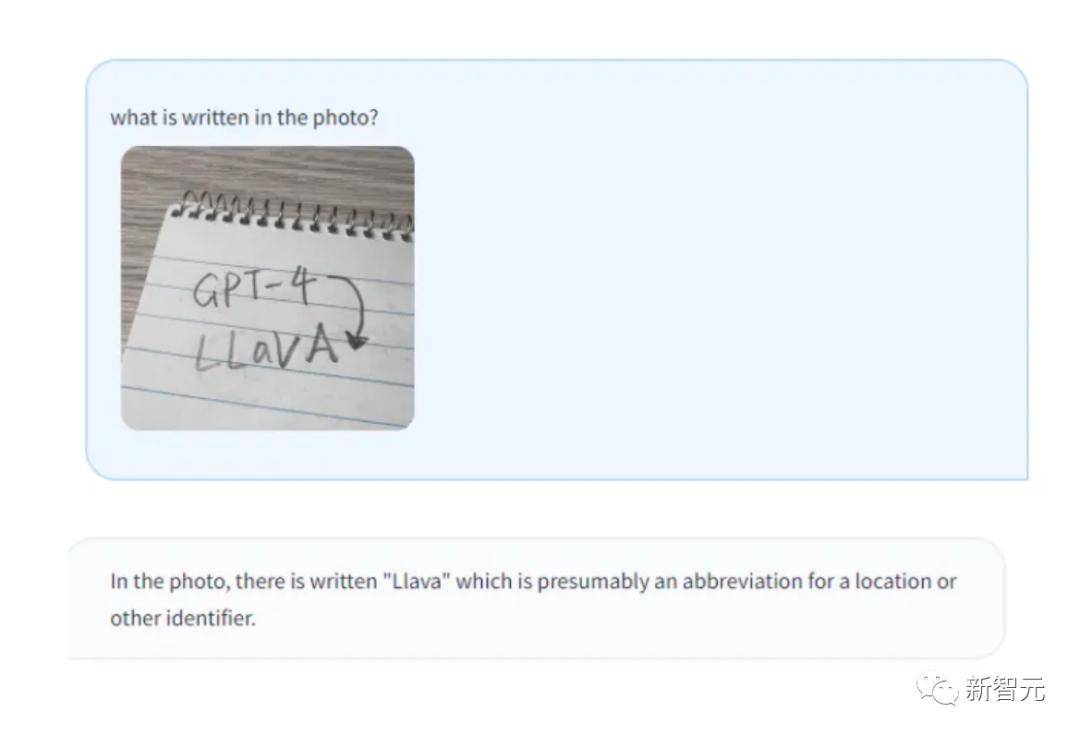

OCR識別,LLaVA的性能也很強(qiáng)大。

CogAgent

CogAgent是在CogVLM基礎(chǔ)上改進(jìn)的開源視覺語言模型,來自清華的研究者。

CogAgent-18B有110億個視覺參數(shù),和70億個語言參數(shù)。

論文地址:https://arxiv.org/pdf/2312.08914.pdf

在9個經(jīng)典的跨模態(tài)基準(zhǔn)(包括VQAv2、OK-VQ、TextVQA、ST-VQA、ChartQA、infoVQA、DocVQA、MM-Vet和POPE)上,CogAgent-18B實(shí)現(xiàn)了最先進(jìn)的通用性能。

在AITW和Mind2Web等圖形用戶界面操作數(shù)據(jù)集上,它大大超過了現(xiàn)有模型。

除了CogVLM已有的所有功能(可視化多輪對話、可視化接地)外,CogAgent.NET還提供了更多的功能:

圖形用戶界面代理(GUI Agent)1.支持更高分辨率的視覺輸入和對話答題。支持1120x1120的超高分辨率圖像輸入。

2.具備可視化代理的能力,能夠在任何圖形用戶界面截圖上返回任何給定任務(wù)的計(jì)劃、下?步行動和帶有坐標(biāo)的具體操作。

3.增強(qiáng)了與圖形用戶界面相關(guān)的問題解答功能,使其能夠處理與網(wǎng)頁、PC應(yīng)用程序、移動應(yīng)用程序等任何圖形用戶界面截圖相關(guān)的問題。

4.通過改進(jìn)預(yù)培訓(xùn)和微調(diào),增強(qiáng)了OCR相關(guān)任務(wù)的能力。

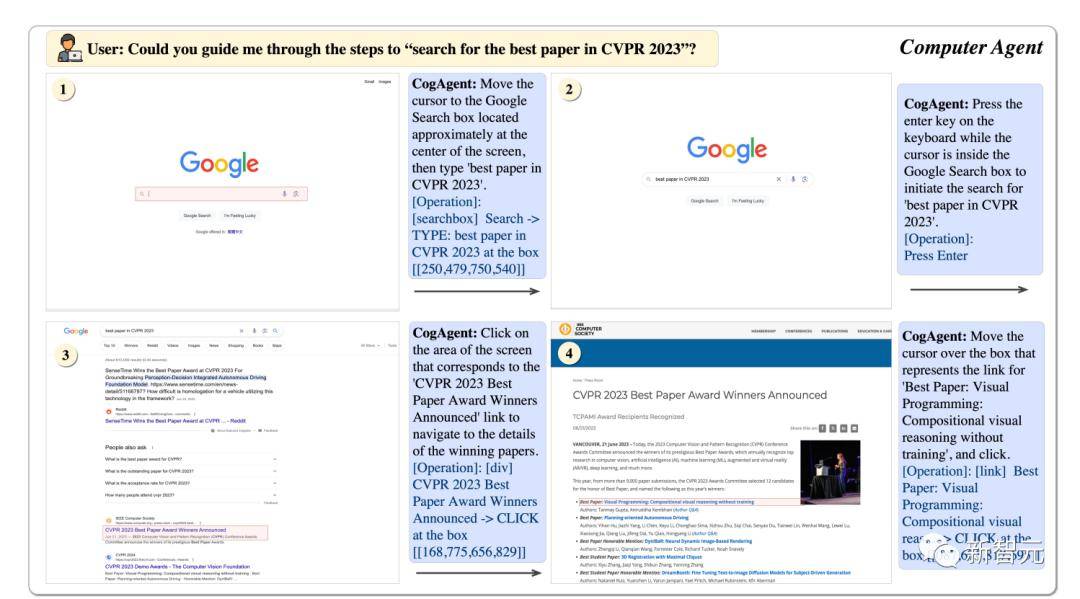

利用CogAgent,它可以幫我們一步步找到CVPR23的最佳論文。

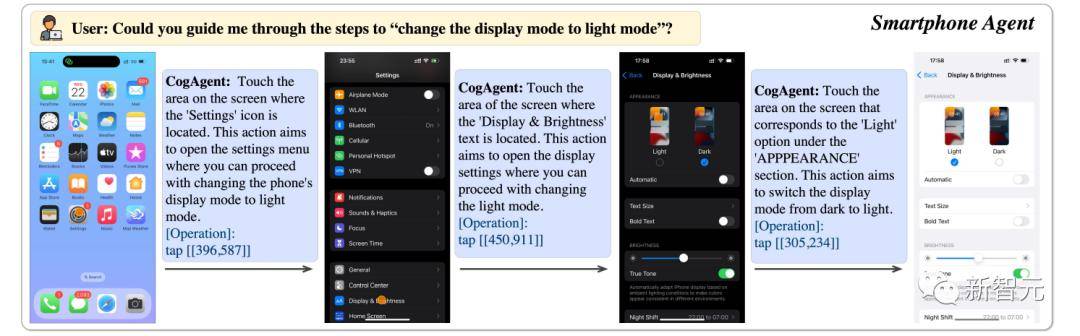

可以幫我們把手機(jī)顯示調(diào)成明亮模式。

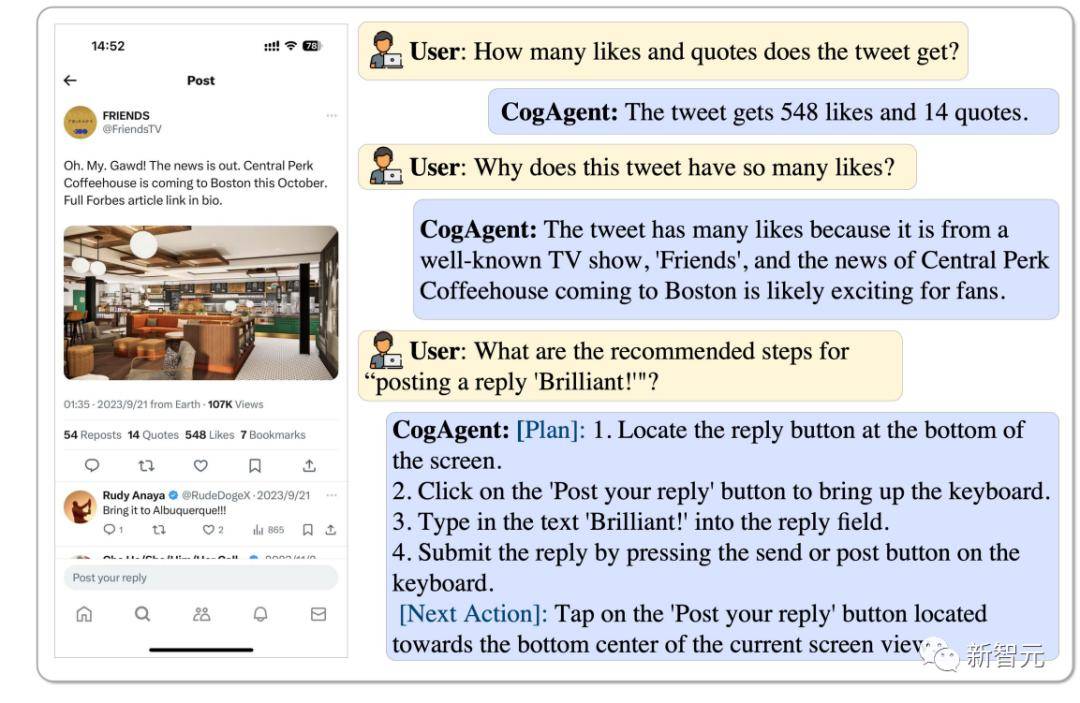

這條推文有多少轉(zhuǎn)評贊,為什么如此受歡迎,CogAgent都能分析出來,甚至連回復(fù)一個“Brilliant”,它都能操作。

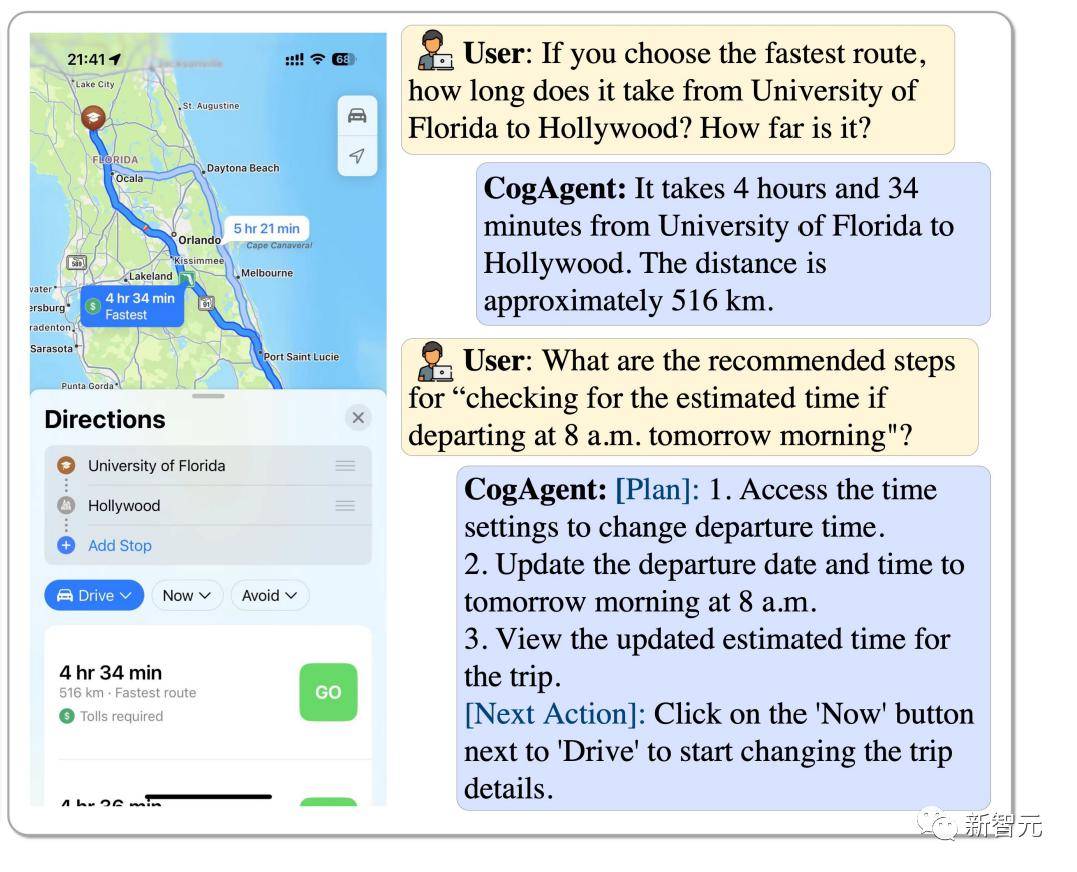

從弗羅里達(dá)大學(xué)到好萊塢,怎樣選擇最快的路線?如果從早上8點(diǎn)出發(fā),該如何評估需要花多長時間?CogAgent都可以回答。

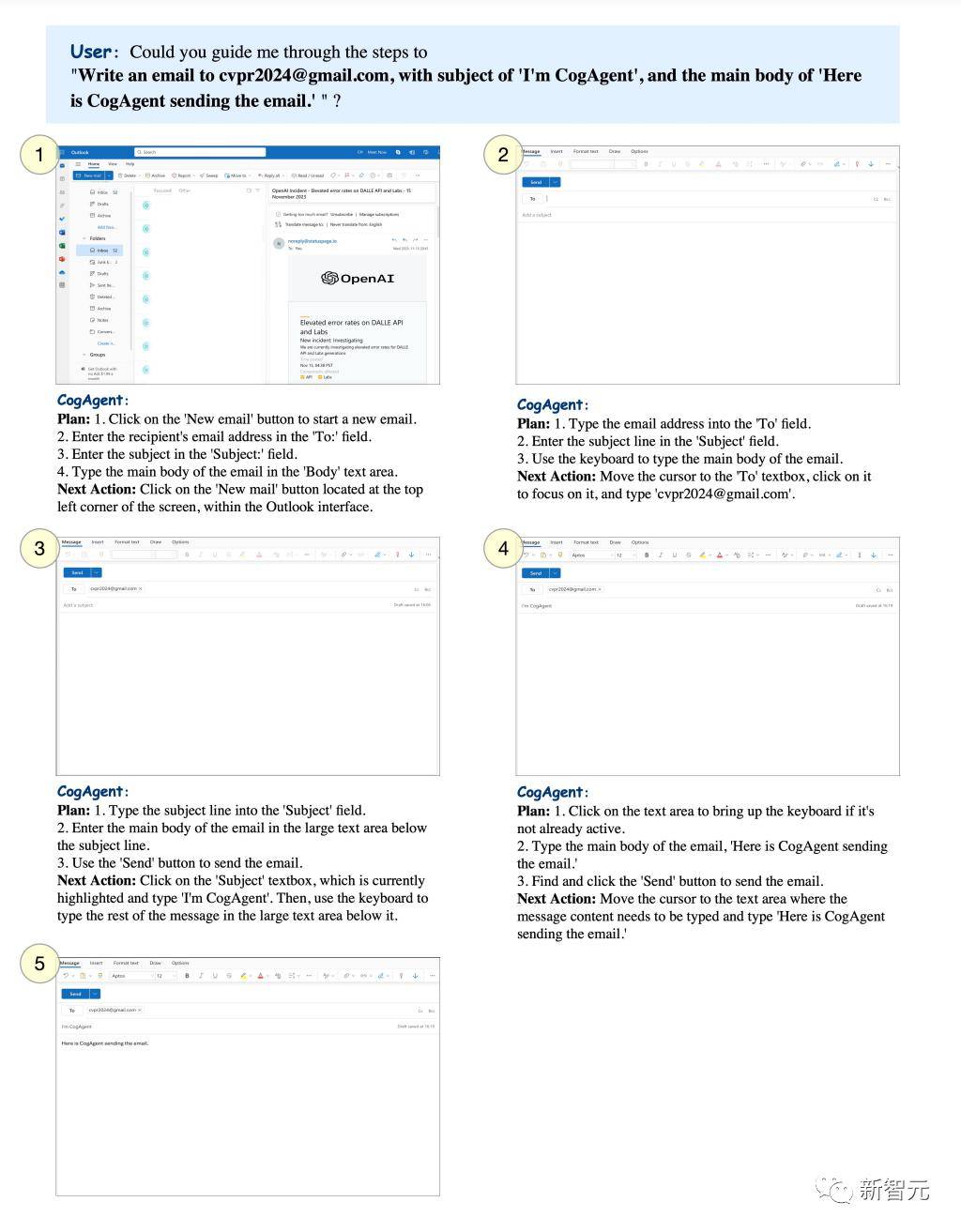

可以設(shè)定特定的主題,讓CogAgent往指定的郵箱里發(fā)郵件。

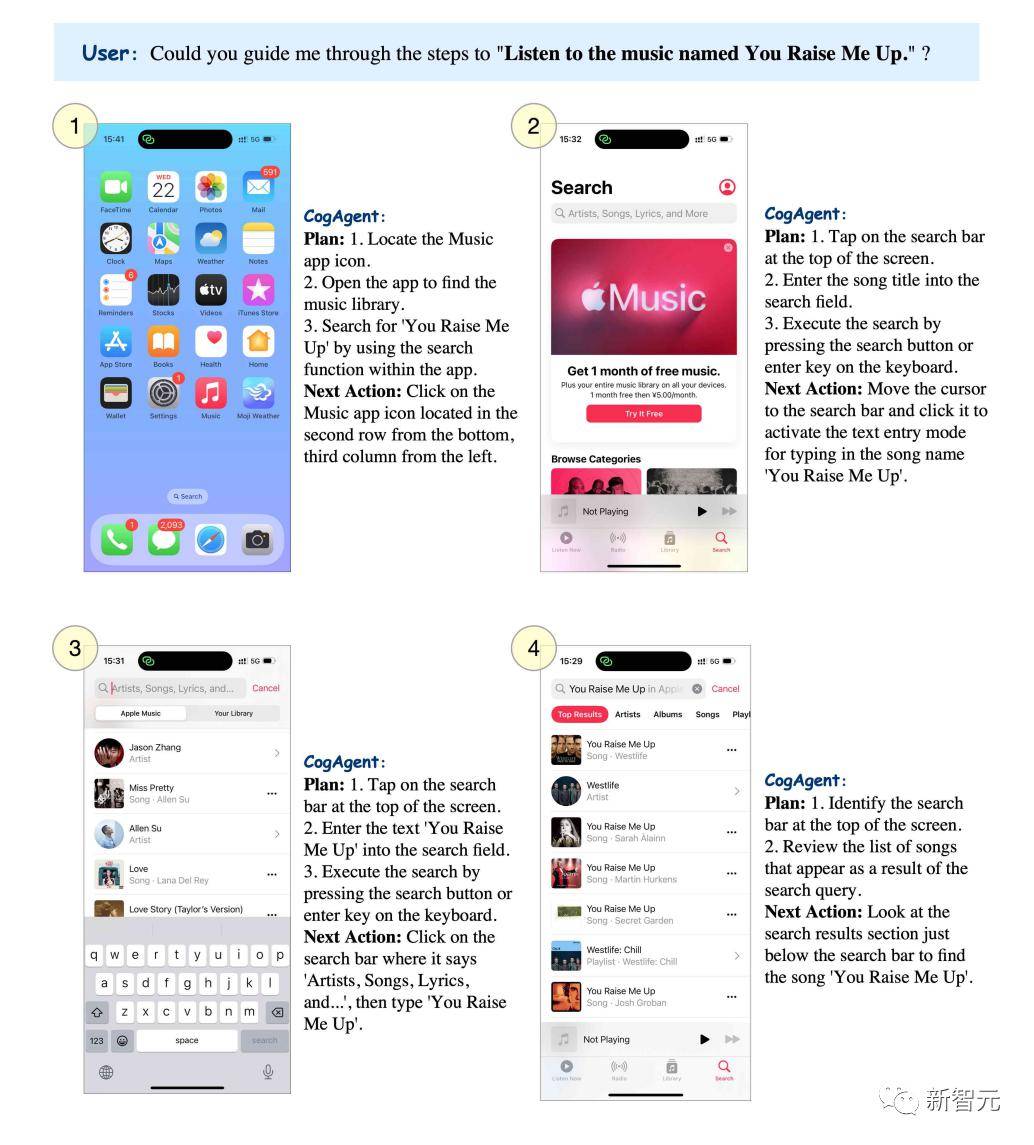

想聽一首<You raise me up>,CogAgent可以一步步列出步驟。

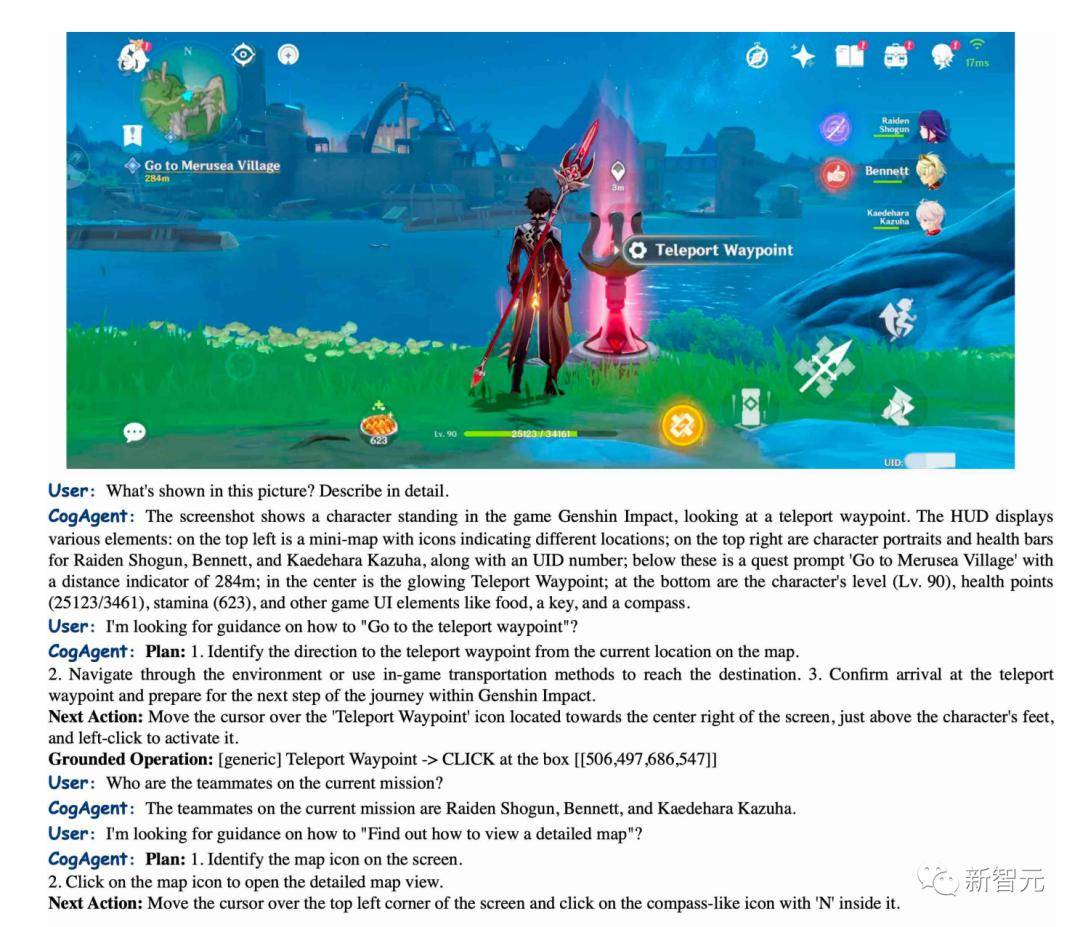

CogAgent能精準(zhǔn)地描述出《原神》中的畫面,還能引導(dǎo)你如何走到傳送點(diǎn)。

BakLLaVA

BakLLaVA1是使用LLaVA 1.5架構(gòu)增強(qiáng)的Mistral 7B基礎(chǔ)模型。

在第?個版本中,Mistral 7B基礎(chǔ)模型在多個基準(zhǔn)測試中優(yōu)于Llama 2 13B。

在他們的repo中,就可以運(yùn)行BakLLaVA-1了。頁面還在不斷更新中,以方便微調(diào)和推理。(https://Github.com/SkunkworksAI/BakLLaVA)

BakLLaVA-1是完全開源的,但在某些數(shù)據(jù)上進(jìn)行了訓(xùn)練,其中包括LLaVA的語料庫,因此不允許商用。

BakLLaVA 2采用了更大的數(shù)據(jù)集和更新的架構(gòu),超越了當(dāng)前的LLaVa方法。BakLLaVA擺脫了BakLLaVA-1的限制,可以商用。

參考資料:

https://yousefhosni.medium.com/discover-4-open-source-alternatives-to-gpt-4-vision-82be9519dcc5