什么是Python/ target=_blank class=infotextkey>Python爬蟲框架?

就像超市里有賣半成品的菜一樣,Python爬蟲工具也有半成品,就是Python爬蟲框架。就是把一些常見的爬蟲功能的代碼先寫好,然后留下一些借口。當我們在做不同的爬蟲項目時,根據(jù)項目的實際情況,稍微變動一下,并按照需求調(diào)用這些接口,就可以完成一個爬蟲項目了。

是不是很心動?再也不用辛辛苦苦碼代碼了。下面,好學編程給大家分享一些高效好用的爬蟲框架。

1.Scrapy

Scrapy框架是一套比較成熟的Python爬蟲框架,可以高效的爬取web頁面并提取出結(jié)構(gòu)化數(shù)據(jù),用這個框架可以輕松爬下來如亞馬遜商品信息之類的數(shù)據(jù)。

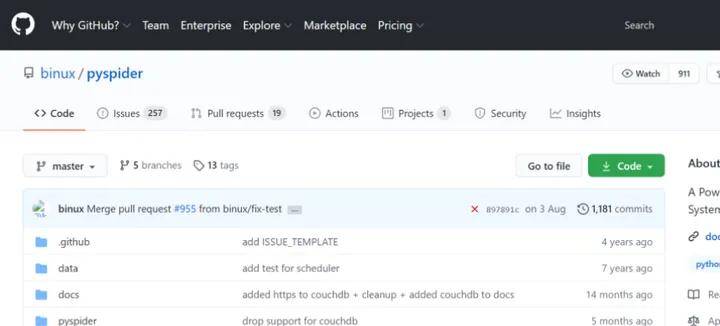

2.PySpider

pyspider 是一個用python實現(xiàn)的功能強大的網(wǎng)絡爬蟲系統(tǒng),能在瀏覽器界面上進行腳本的編寫,功能的調(diào)度和爬取結(jié)果的實時查看,后端使用常用的數(shù)據(jù)庫進行爬取結(jié)果的存儲,還能定時設置任務與任務優(yōu)先級等。

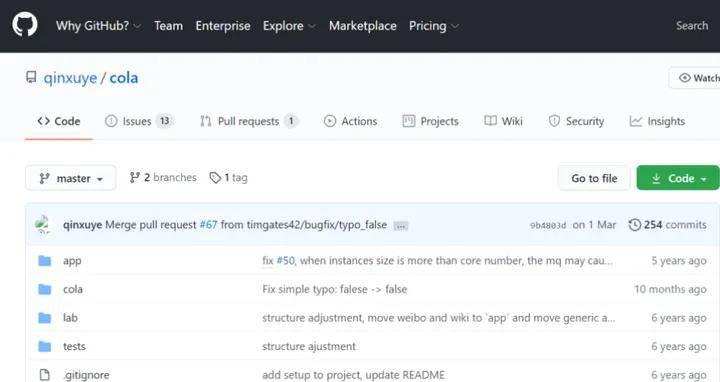

3.Cola

Cola是一個分布式的爬蟲框架,對于用戶來說,只需編寫幾個特定的函數(shù),而無需關(guān)注分布式運行的細節(jié)。任務會自動分配到多臺機器上,整個過程對用戶是透明的。

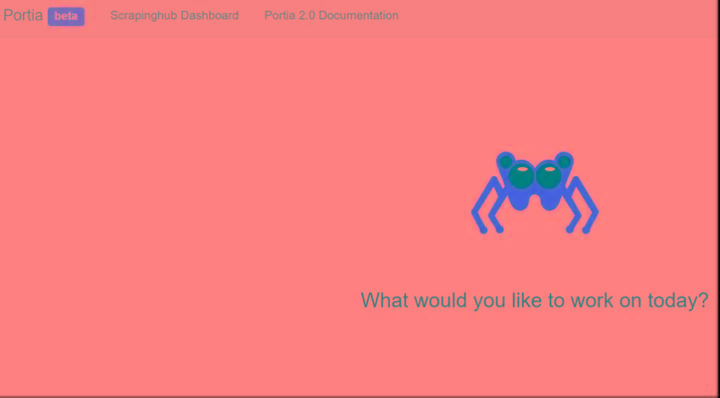

4.Portia

Portia是一款不需要任何編程知識就能爬取網(wǎng)頁的爬蟲框架,只要將相關(guān)信息填好之后,就可以爬取網(wǎng)站了。

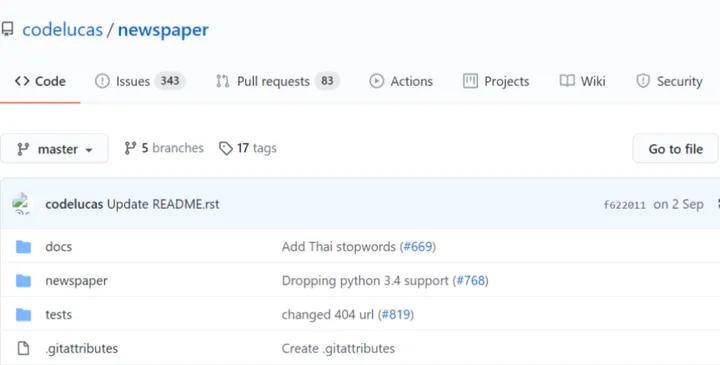

5.Newspaper

Newspaper框架是一個用來提取新聞、文章以及內(nèi)容分析的Python爬蟲框架。

6.Beautiful Soup

Beautiful Soup整合了一些常用的爬蟲需求,可以從html或XML文件中提取數(shù)據(jù)的Python庫。它能夠通過你喜歡的轉(zhuǎn)換器實現(xiàn)慣用的文檔導航、查找、修改文檔的方式,會幫你節(jié)省數(shù)小時甚至數(shù)天的工作時間。

7.Grab

Grab可以構(gòu)建各種復雜的網(wǎng)頁抓取工具,從簡單的5行腳本到處理數(shù)百萬個網(wǎng)頁的復雜異步網(wǎng)站抓取工具。

8.Crawley

Crawley可以高速爬取對應網(wǎng)站的內(nèi)容,支持關(guān)系和非關(guān)系數(shù)據(jù)庫,數(shù)據(jù)可以導出為JSON、XML等。

9.Selenium

Selenium 是自動化測試工具。它支持各種主流界面式瀏覽器,如果在這些瀏覽器里面安裝一個 Selenium 的插件,可以方便地實現(xiàn)Web界面的測試。

10 .Python-goose

Python-goose框架可提取包括文章內(nèi)容、文章圖片、文章中嵌入的任何視頻、元描述、元標簽。

以上就是本次分享的全部內(nèi)容,想學習更多編程技巧,歡迎持續(xù)關(guān)注好學編程!